Por Ernesto Spinak

O contexto

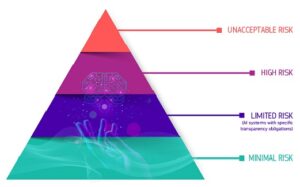

Imagem: European Comission.

Informes indicam que

a base de dados de vírus pode ser consideravelmente ampliada mediante a utilização de técnicas de inteligência artificial, que gerarão novos produtos químicos, que podem produzir novos vírus… compelir o modelo generativo em direção a compostos como o agente nervoso VX, um dos agentes químicos de guerra mais tóxicos desenvolvidos durante o século XX.”1

Foi feito e funcionou: “Em menos de 6 horas após o seu lançamento no nosso servidor interno, o modelo gerou 40.000 moléculas que obtiveram resultados dentro do limiar desejado.”1

De acordo com o informe, algumas das moléculas produzidas pela inteligência artificial (IA) eram ainda “mais tóxicas do que o VX”, um agente nervoso tóxico desenvolvido pelo Laboratório de Ciência e Tecnologia da Defesa do Reino Unido na década de 1950, que mata suas vítimas por meio de paralisia muscular.

Foram quatro pesquisadores envolvidos na descoberta de medicamentos por meio da IA que alertaram para o fato de a tecnologia da IA poder ser facilmente manipulada para produzir agentes nervosos tóxicos, que poderiam depois ser utilizados em guerras biológicas ou químicas.

O Instituto Federal Suíço de Proteção Nuclear, Biológica e Química encarregou os pesquisadores de testar se a IA poderia ser manipulada para fins maléficos. Em apenas seis horas, conseguiram produzir não uma ou duas, mas 40.000 drogas potencialmente tóxicas.

De forma geral, anuncia-se que

os pesquisadores estão encontrando novas formas de utilizar a IA como arma, e o bioterrorismo viabilizado por meio da IA está no topo da lista. Assume-se que ataques biológicos são competência de governos, mas agora enfrentamos a perspectiva de indivíduos e organizações mal-intencionados adquirirem esta capacidade. Transformar um agente patogênico num ataque terrorista exigia anteriormente muitos especialistas, mas os recentes avanços na engenharia genética, combinados com a IA, reduziram drasticamente as competências, o tempo e os recursos necessários.”2

Mas não tinham os chatbox protocolos incorporados para impedir consultas e/ou respostas a tópicos restritos por várias razões? Na verdade, não é desta forma, porque os pesquisadores da Universidade Carnegie Mellon descobriram como produzir respostas não permitidas a pedidos maliciosos a sistemas de inteligência artificial. Isto foi feito através da injeção de código que é depois interpretado/executado pelo aplicativo. Este tipo de ataque explora a manipulação incorreta de dados não confiáveis, inserindo código programado no prompt (code-injection).

Se quiser, você pode ter uma experiência pessoal direta acessando o artigo A New Attack Impacts ChatGPT—and No One Knows How to Stop It.3 Desde a programação de ataques terroristas até o projeto de bombas nucleares (ou quase).

A legislação iminente

À medida que a IA se acelera, o mesmo acontece com as tentativas de regulamentação. Cada país busca ter seu próprio conjunto de regras, o que pode levar a uma maior fragmentação do mercado digital global. Os riscos associados à IA, seja gerando desinformação, perda de empregos ou preconceito, são os principais motivos por trás do movimento em direção à regulamentação.

Em um breve resumo podemos dizer que:

- A União Europeia (UE) assumiu a liderança com as regras mais rígidas, que terão o maior impacto em nível global.

- As regras da China também são rígidas, mas seu impacto é doméstico e voltado para a manutenção do controle e do poder do partido governante.

- Os EUA favorecem a inovação e seu sistema político dificulta qualquer tentativa de regulamentação, dando aos tribunais e aos estados um poder desordenado.

- De qualquer forma, as regulamentações de IA contribuirão ainda mais para a fragmentação e a regionalização, que se tornaram uma tendência importante no mundo da tecnologia.

A UE quer continuar sendo o órgão regulador de tecnologia do mundo. Assim como em outras regulamentações digitais, a UE assumiu a liderança em relação aos EUA ou à China.

A Diretoria de Responsabilidade de IA, ainda em discussão, concentra-se em algoritmos e coloca o ônus da prova na empresa e não no usuário; se houver algum dano, as empresas terão que provar que seus sistemas não foram prejudiciais, ao invés de demonstrar que os usuários o foram.

Os EUA têm um sistema político disfuncional que, embora desconfie da China, sempre favoreceu a inovação em detrimento da regulamentação e preferiria que o mercado introduzisse seus próprios princípios de autorregulamentação.

A regulamentação chinesa trata de poder e controle. Embora possa haver uma calmaria em termos de regulamentação geral de tecnologia na China, este não é o caso da IA, e espera-se que um conjunto completo de regulamentações seja aprovado até o final deste ano. As regras se concentrarão em responsabilidade, privacidade, precisão e desinformação, o que as torna as mais próximas das regras da UE em qualquer lugar do mundo, embora sejam aplicáveis sob um regime muito diferente.

Em última análise, a questão se resume a “As empresas devem ter responsabilidades sociais ou elas existem apenas para gerar lucros para seus acionistas?”4 Se você perguntar a uma IA, poderá obter respostas muito diferentes, dependendo de para qual delas você perguntar.

Isso ocorre porque os modelos de linguagem de IA contêm diferentes vieses políticos, de acordo com uma nova pesquisa da Universidade de Washington, da Universidade Carnegie Mellon e da Universidade Xi’an Jiaotong. Os pesquisadores testaram 14 modelos de Large Language Model (LLM) e descobriram que o ChatGPT e o GPT-4 da OpenAI eram mais de esquerda, enquanto o LLaMA da Meta era mais autoritário e de direita.

À medida que os modelos de linguagem de IA são implementados em produtos e serviços usados por milhões de pessoas, pode ser importante entender suas suposições subjacentes e tendências políticas. Isso porque eles têm o potencial de causar danos reais se oferecerem conselhos tendenciosos, seja na esfera jurídica ou da saúde.

O que abrange o projeto de regulamentação da UE sobre inteligência artificial

A UE está finalizando sua Lei de IA como a primeira regulamentação abrangente do mundo para IA e, há algumas semanas, o Parlamento Europeu adotou uma minuta da lei por 499 votos a favor, 28 contra e 93 abstenções.

Além disso, a UE é a iniciativa regulatória de IA mais importante do mundo atualmente. A lei não apenas imporá requisitos para a IA na UE, uma população de 450 milhões de pessoas, mas também estabelecerá um precedente para a regulamentação da IA em todo o mundo.

Estabelece-se uma classificação para sistemas de IA com diferentes requisitos e obrigações adaptados a uma “abordagem baseada em riscos”. Certos sistemas de IA que apresentam riscos “inaceitáveis” seriam proibidos. Uma ampla gama de sistemas de IA de “alto risco” seria autorizada, porém sujeita a uma série de requisitos e obrigações para acessar o mercado da UE.

Os sistemas de IA que apresentassem apenas “risco limitado” seriam aceitos, sendo que a prioridade seria considerar as implicações dos sistemas de IA para os direitos fundamentais protegidos pela Carta dos Direitos Fundamentais da UE.

Em especial, os sistemas de IA podem comprometer direitos, como o direito à não discriminação, à liberdade de expressão, à dignidade humana, à proteção de dados pessoais e à privacidade.

A Comissão concluiu que a noção de um sistema de IA deve ser definida com mais clareza para garantir a segurança jurídica, uma vez que a determinação do que constitui um “sistema de IA” é crucial para a atribuição de responsabilidades jurídicas no âmbito da nova estrutura de IA.

Esta abordagem baseada em riscos é expressa na pirâmide de riscos, na qual os riscos são categorizados da seguinte forma:

Risco inaceitável: Práticas de IA proibidas

- A lei de IA proíbe explicitamente práticas nocivas de IA;

- Sistemas de IA que implementam ”técnicas subliminares” prejudiciais de manipulação;

- Sistemas de IA que exploram grupos vulneráveis específicos (deficiência física ou mental);

- Sistemas de IA usados por ou em nome de autoridades públicas para fins de pontuação social;

- Sistemas de identificação biométrica remota em tempo real em espaços acessíveis ao público para fins de aplicação da lei, exceto em um número limitado de casos.

Alto risco: sistema de IA de alto risco regulado

- Sistemas de IA de alto risco implantados em oito áreas específicas;

- Identificação biométrica e categorização de pessoas físicas;

- Gerenciamento e operação de infraestrutura crítica;

- Educação e formação profissional;

- Emprego, gerenciamento de trabalhadores e acesso ao trabalho autônomo;

- Acesso e usufruto de serviços privados essenciais e serviços e benefícios públicos;

- Monitoramento do cumprimento da lei;

- Gestão de migração, asilo e controle de fronteiras;

- Administração da justiça e processos democráticos.

Risco limitado: Obrigações de transparência

- Sistemas de IA que apresentam “risco limitado”, como sistemas que interagem com humanos (ou seja, chatbots), sistemas de reconhecimento de emoções, sistemas de categorização biométrica e sistemas de IA que geram ou manipulam conteúdo de imagem, áudio ou vídeo (deep-fake), estariam sujeitos a um conjunto limitado de obrigações de transparência.

Risco baixo ou mínimo: sem obrigações

- No entanto, a lei de IA proposta prevê a criação de códigos de conduta para incentivar os provedores de sistemas de IA que não sejam de alto risco a implementar voluntariamente os requisitos obrigatórios para os de alto risco.

Como está a situação atual da indústria de IA?

Uma análise da Universidade de Stanford e uma avaliação da conformidade das 10 principais plataformas de IA atuais, medindo 22 variáveis, concluem que:

- Os provedores de modelos básicos geralmente não cumprem os requisitos preliminares para descrever o uso de dados de treinamento protegidos por direitos autorais, o hardware usado, as emissões produzidas no treinamento e como os modelos são avaliados e testados.

- Os resultados mostram uma variedade surpreendente de conformidade entre os provedores de modelos básicos: alguns provedores (AI21 Labs, Aleph Alpha, Anthropic) têm pontuação abaixo de 25% e apenas dois provedores (Hugging Face; BigScience) obtiveram pontuação mínima de 75% no momento.

- Poucos provedores divulgam informação sobre o status dos direitos autorais dos dados de treinamento. Muitos modelos básicos são treinados com base em dados selecionados na internet, uma fração considerável dos quais provavelmente está protegida por direitos autorais.

- Os provedores de modelos básicos raramente medem o desempenho do modelo em termos de danos intencionais, como uso malicioso, ou fatores como robustez e calibração.

- Muitos membros da comunidade pediram mais avaliações, mas os padrões para a avaliação do modelo básico (especialmente além dos modelos linguísticos) continuam sendo apenas um “trabalho em curso”.

- Os informes para GPT-4 da OpenAI e PaLM 2 do Google afirmam abertamente que não informam muitos aspectos relevantes sobre dados e computação.

- A transparência deveria ser a primeira prioridade.

Nossa reflexão

Acreditamos que os provedores de modelos básicos estão cumprindo de forma desigual os requisitos estabelecidos no projeto de lei de IA da UE. Portanto, os provedores de tais modelos devem continuar a trabalhar para atender aos padrões do setor.

A promulgação e a implementação da Lei de IA da UE provocarão uma mudança positiva e significativa no ecossistema do modelo básico.

O chatbox discutido no exemplo acima, um sistema que foi hackeado por code-injection, foi corrigido imediatamente após a publicação do artigo. Se quiser construir bombas nucleares, terá que encontrar outro modelo. Se conseguir, não é necessário nos informar.

Posts da série sobre Inteligência Artificial (IA)

- GPT, tradução automática e o quão bons eles são: uma avaliação abrangente

- Inteligência Artificial e a comunicação da pesquisa

- IA: Como detectar textos produzidos por chatbox e seus plágios

- Pesquisa e comunicação científica, IA e legislação iminente

- ¿Puede la IA hacer arbitrajes confiables de artículos científicos? (apenas em espanhol)

- ¿Es que la Inteligencia Artificial tiene alucinaciones? (apenas em espanhol)

Notas

1. MILLER, A. Bioweapons Designed by AI: a ‘Very Near-Term Concern,’ Schmidt Says [online]. Air&Space Forces Magazine. 2022 [viewed 24 November 2023]. Available from: https://www.airandspaceforces.com/bioweapons-designed-by-ai-a-very-near-term-concern-schmidt-says/

2. HEATH, R. Another AI threat: The next pandemic. AXIOS. 2023 [viewed 24 November 2023]. Available from: https://www.axios.com/2023/06/16/pandemic-bioterror-ai-chatgpt-bioattacks

3. KNIGHT, W. A New Attack Impacts ChatGPT—and No One Knows How to Stop It [online]. Wired. 2023 [viewed 24 November 2023]. Available from: https://www.wired.com/story/ai-adversarial-attacks/

4. HEIKKILÄARCHIVE, M. AI language models are rife with different political biases [online]. 2023. [viewed 24 November 2023]. Available from: https://www.technologyreview.com/2023/08/07/1077324/ai-language-models-are-rife-with-political-biases/

5. BOMMASANI, R., et al. Do Foundation Model Providers Comply with the Draft EU AI Act? [online]. Stanford CRFM [viewed 24 November 2023]. Available from: https://crfm.stanford.edu/2023/06/15/eu-ai-act.html

Referências

BOMMASANI, R., et al. Do Foundation Model Providers Comply with the Draft EU AI Act? [online]. Stanford CRFM [viewed 24 November 2023]. Available from: https://crfm.stanford.edu/2023/06/15/eu-ai-act.html

EU AI Act: first regulation on artificial intelligence [online]. European Parliament. 2023 [viewed 24 November 2023]. Available from: https://www.europarl.europa.eu/news/en/headlines/society/20230601STO93804/eu-ai-act-first-regulation-on-artificial-intelligence

GARG, M.K. AI comes up with 40,000 toxic chemicals in 6 hours; scientists warn could be used to make biological weapons [online]. Wion News. 2023 [viewed 24 November 2023]. Available from: https://www.wionews.com/technology/ai-comes-up-with-40000-toxic-chemicals-in-6-hours-scientists-warn-could-be-used-to-make-biological-weapons-561636

HEATH, R. Another AI threat: The next pandemic. AXIOS. 2023 [viewed 24 November 2023]. Available from: https://www.axios.com/2023/06/16/pandemic-bioterror-ai-chatgpt-bioattacks

HEIKKILÄARCHIVE, M. AI language models are rife with different political biases [online]. 2023. [viewed 24 November 2023]. Available from: https://www.technologyreview.com/2023/08/07/1077324/ai-language-models-are-rife-with-political-biases/

How governments are looking to regulate AI [online]. Economist Intelligence Unit. 2023 [viewed 24 November 2023]. Available from: https://www.eiu.com/n/how-governments-are-looking-to-regulate-ai/

KNIGHT, W. A New Attack Impacts ChatGPT—and No One Knows How to Stop It [online]. Wired. 2023 [viewed 24 November 2023]. Available from: https://www.wired.com/story/ai-adversarial-attacks/

MADIEGA, T. Artificial Intelligence Act. Briefing [online]. European Parliament. 2023 [viewed 24 November 2023]. Available from: https://www.europarl.europa.eu/RegData/etudes/BRIE/2021/698792/EPRS_BRI(2021)698792_EN.pdf

MILLER, A. Bioweapons Designed by AI: a ‘Very Near-Term Concern,’ Schmidt Says [online]. Air&Space Forces Magazine. 2022 [viewed 24 November 2023]. Available from: https://www.airandspaceforces.com/bioweapons-designed-by-ai-a-very-near-term-concern-schmidt-says/

URBINA, F., et al. Dual use of artificial-intelligence-powered drug discovery. Nat Mach Intell [online].2022, vol. 4, pp. 189-191 [viewed 24 November 2023]. https://doi.org/10.1038/s42256-022-00465-9. Available from: https://www.nature.com/natmachintell/

Sobre Ernesto Spinak

Colaborador do SciELO, engenheiro de Sistemas e licenciado em Biblioteconomia, com diploma de Estudos Avançados pela Universitat Oberta de Catalunya e Mestre em “Sociedad de la Información” pela Universidad Oberta de Catalunya, Barcelona – Espanha. Atualmente tem uma empresa de consultoria que atende a 14 instituições do governo e universidades do Uruguai com projetos de informação.

Traduzido do original em espanhol por Lilian Nassi-Calò.

Como citar este post [ISO 690/2010]:

Últimos comentários