Por Ernesto Spinak

Introdução

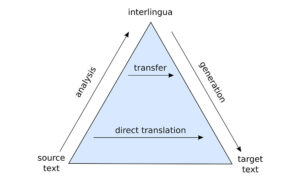

Imagem: Wikimedia Commons, 1934.

O uso de inteligência artificial (IA), em particular na tradução automática de textos científicos, é um avanço irreversível na publicação científica. Estas ferramentas de apoio são comuns e aceitas no processo editorial por todas as sociedades científicas.

No estudo pertinente, analisa-se o estado da arte dos tradutores mais avançados e de uso generalizado, onde se comprova a confiabilidade destas ferramentas de apoio à pesquisa. Publicações recentes no arXiv são usadas como fontes: How Good Are GPT Models at Machine Translation? A Comprehensive Evaluation,1 In-context Example Selection for Machine Translation2 e os documentos da Conference of Machine Translation (WMT).3

Contexto do experimento

Os recursos de tradução multilíngue das versões mais recentes do GPT-3.5 e dos sistemas Neural Machine Translation (NMT) em diferentes domínios temáticos foram comparados.

GPT-3.5 é uma versão avançada da arquitetura GPT (Generative Pre-trained Transformer). Esta arquitetura é baseada em uma rede neural chamada Transformer, que utiliza mecanismos de atenção para processar e gerar texto. O modelo é treinado em grandes quantidades de dados textuais para aprender padrões linguísticos e contextuais, permitindo gerar respostas consistentes e relevantes com base no contexto da conversa.

As versões usadas foram: GPT3.5 (text-davinci-003, e text-davinci-002), que são diferentes versões do modelo de linguagem GPT desenvolvido por OpenAI com diferentes características.

- Capacidade e tamanho:5 (text-davinci-003) é uma versão mais recente e maior, em comparação com text-davinci-002; capacidade de geração de texto mais avançada e uma maior quantidade de conhecimento e contexto a sua disposição.

- Treinamento: As diferentes versões do modelo GPT são treinadas com distintos conjuntos de dados e técnicas de aprendizagem. GPT3.5 é treinado com uma grande quantidade de dados textuais de alta qualidade provenientes da web, o que lhe permite ter um conhecimento mais atualizado, extenso e integral (a versão do GPT3.5 foi treinada com dados até 2022).

- Rendimento e qualidade de resposta:5 (text-davinci-003) é considerada uma versão melhorada e se espera que gere respostas mais coerentes e precisas.

Por outro lado, os sistemas Neural Machine Translation (NMT) são enfoques diferentes daqueles usados pelo GPT para a tradução automática. A seguir, são apresentadas algumas diferenças chave entre eles:

O GPT-3.5 é treinado com grandes quantidades de dados textuais gerais de vários domínios e não se concentra exclusivamente em tradução. Por outro lado, os sistemas NMT são treinados especificamente em pares de frases em diferentes idiomas para aprender a traduzir de forma mais precisa e específica.

Os sistemas NMT geralmente são mais especializados para tradução automática e são projetados para otimizar a qualidade da tradução em domínios e pares de idiomas específicos. GPT-3.5, embora capaz de realizar traduções, não é especificamente otimizado para tradução automática e pode ter limitações em termos de terminologia especializada e consistência no contexto científico.

Os idiomas considerados neste estudo incluem: inglês, francês, alemão, tcheco, islandês, chinês, japonês, russo, ucraniano e hausa (abrangendo vários alfabetos e continentes).

Existem vários sistemas de tradução de acesso aberto que são amplamente utilizados na comunidade de tradução automática. Alguns dos principais tradutores de acesso aberto podem ser vistos na nota 4.

- DeepL utiliza uma arquitetura de redes neurais chamada Redes Neurais Recorrentes Profundas (Deep Recurrent Neural Networks, DRNN) para seu sistema de tradução automática. Esta arquitetura está fundamentada em LSTM (Long Short-Term Memory) e demostrou ser eficaz em tarefas de tradução.

- Google Translate utiliza uma arquitetura de tradução automática chamada Google Neural Machine Translation (GNMT), que é um enfoque baseado em redes neurais para a tradução automática. Esta arquitetura se baseia na arquitetura Transformer, que é uma rede neural que utiliza mecanismos de atenção para processar e traduzir texto.

- Microsoft oferece um serviço de tradução automática chamado Microsoft Translator. É um sistema baseado na tecnologia de tradução automática neural (Neural Machine Translation, NMT) e foi desenhado para traduzir texto de maneira eficiente e precisa entre diferentes idiomas.

- OpenNMT é um projeto de código aberto que oferece um marco para a construção e treinamento de sistemas de tradução neural. Utiliza arquitetura de redes neurais como LSTM (Long Short-Term Memory) e Transformer para a tradução automática.

- Marian NMT é outro sistema popular de tradução neural de acesso aberto. É baseado na arquitetura Transformer e oferece implementações eficientes para a tradução automática.

Estes são apenas alguns exemplos de tradutores de acesso aberto amplamente utilizados. Cabe destacar que as arquiteturas mencionadas, como LSTM e Transformer, são utilizadas em muitos sistemas de tradução neural devido à sua capacidade para capturar relações de longo prazo no texto e processar eficientemente sequências de palavras. No entanto, cada sistema pode ter implementações e configurações específicas adaptadas às suas necessidades.

DeepL recebeu reconhecimento por sua qualidade de tradução e foi especialmente elogiado por sua capacidade para manter a coerência e produzir traduções naturais. Além disso, o sistema de tradução do DeepL se beneficiou do treinamento em grandes conjuntos de dados multilingues – 31 idiomas – para melhorar ainda mais a precisão e a fluidez das traduções.

Google investiu significativamente no desenvolvimento e treinamento de modelos de tradução automática baseados na arquitetura GNMT. Ademais, foram aplicadas técnicas de aprendizagem automática avançadas, como o treinamento com grandes conjuntos de dados e o uso de técnicas de aumento de dados, para melhorar a qualidade e precisão das traduções geradas por Google Translate – que inclui mais de 110 idiomas.

The Conference on Machine Translation (WMT)

A Conference on Machine Translation (WMT) desempenha um papel crucial na avaliação e comparação da tecnologia de tradução automática. WMT, com cobertura mundial, é um evento anual enfocado na avaliação e no progresso dos sistemas de tradução automática.

No âmbito do WMT, são organizados desafios de tradução automática dos quais podem participar pesquisadores e desenvolvedores de todo o mundo. Estes desafios geralmente incluem conjuntos de dados de treinamento e teste, que consistem em pares de sentenças em diferentes idiomas. Os participantes treinam seus modelos de tradução automática usando os dados de treinamento fornecidos e, em seguida, avaliam e comparam seus sistemas usando os dados de teste.

Os dados de teste utilizados na WMT geralmente são coletados e preparados especificamente para cada edição do evento. O processo de obtenção dos dados do teste pode variar, dependendo do ano e dos organizadores da conferência, mas aqui estão algumas maneiras comuns de obtê-los:

- Conjuntos de dados públicos: Podem ser utilizados conjuntos de dados públicos disponíveis online, como o Europarl Corpus, conjunto de documentos dos debates no Parlamento Europeu em vários idiomas. Estes conjuntos de dados são, geralmente, de domínio público e são amplamente utilizados para avaliação de sistemas de tradução automática.

- Colaboração com organizações e empresas: WMT com frequência colabora com organizações e empresas que estão dispostas a proporcionar dados de teste para avaliação de sistemas de tradução automática. Estas organizações podem compartilhar dados de diferentes domínios e temas para avaliar a qualidade e a utilidade dos sistemas de tradução automática.

- Compilação de dados específicos: Em alguns casos, dados podem ser compilados especificamente para avaliação de WMT. Isso pode implicar na compilação de textos de diferentes fontes, como livros, artigos, legendas de vídeos ou sites na internet, em uma variedade de idiomas para criar um conjunto diverso de dados para teste.

A nomenclatura utilizada pela WMT para os conjuntos de dados de teste pode variar de uma edição para outra. No entanto, frequentemente se segue uma convenção comum para nomear os conjuntos de dados. A nomenclatura é explicada na nota 5.

Métricas e parâmetros de avaliação

Todos os sistemas de tradução, com suas diferentes arquiteturas, utilizam numerosos parâmetros de configuração e ajustes finos para melhorar a precisão e eficiência da tarefa, que é avaliada de acordo com métricas internacionais usadas pela WMT. Além destes parâmetros objetivos, são complementadas por avaliações humanas formada por linguistas especializados.

A seguir, estão relacionadas algumas das métricas de WMT usadas nos artigos analisados:

- Zero-shot learning (ZSL) é um enfoque de aprendizagem automático que busca abordar o desafio de reconhecer e classificar objetos ou conceitos para os quais não se dispõe de dados de treinamento direto. O objetivo é aprender a reconhecer novas classes ou categorias sem exemplos prévios de treinamento e busca a capacidade de generalizar e reconhecer categorias não abordadas durante o treinamento.

- Language Modeling Bias (Viés de Modelação de Linguagem) se refere aos vieses inerentes ou implícitos que podem estar presentes nos modelos de linguagem devido aos dados de treinamento utilizados para treiná-los. O viés de modelação de linguagem pode surgir devido a vários fatores, incluindo os seguintes:

- Vieses nos dados de treinamento: os modelos de linguagem são treinados em grandes conjuntos de dados que geralmente refletem os vieses existentes na sociedade ou na forma como a linguagem é usada. Estes vieses podem incluir preferências culturais, estereótipos, desigualdades sociais e outras formas de viés linguístico.

- Viés na seleção de dados de treinamento: A seleção de dados de treinamento pode apresentar viés se os conjuntos de dados não representarem adequadamente a diversidade de perspectivas e experiências.

- Reforço de vieses existentes: os modelos de linguagem podem aprender a reforçar e amplificar certos vieses presentes nos dados de treinamento devido à forma como a linguagem é modelada e as respostas são geradas.

- Comparisons of Punctuation Insertions (Comparações de Inserções de Pontuação) é um termo que se refere à avaliação e comparação de diferentes enfoques ou sistemas para inserção de pontuação em um texto. A pontuação, como vírgulas, pontos e sinais de interrogação, desempenha um papel importante na estrutura e compreensão do texto. Estas comparações geralmente avaliam a precisão e a qualidade das inserções de pontuação realizadas por cada sistema em diferentes contextos y cenários.

- Translation Non-Monotonicity (Sem Monotonicidade na Tradução) se refere a um fenômeno na tradução automática onde a relação de correspondência entre as palavras ou frases no texto de origem e no texto de destino não segue uma sequência linear ou monótona. Em outras palavras, a estrutura da tradução não se mantém a ordem do texto original.

Na tradução monotônica, cada elemento no texto de origem é traduzido diretamente do elemento correspondente no texto de destino, sem mudanças significativos na ordem ou na estrutura. No entanto, em alguns casos, especialmente em idiomas com estruturas gramaticais e sintáticas diferentes, a tradução não é monótona e pode implicar em reordenamento ou alterações na estrutura.

- Fluency (Fluidez) se refere à qualidade e naturalidade do texto gerado no idioma de destino. Se avalia como o texto traduzido soa e se lê como se houvesse sido escrito por um falante nativo do idioma de destino.

A fluidez na tradução automática é obtida levando-se em conta aspectos como:

- Gramática e sintaxe: As traduções devem seguir as regras gramaticais e sintáticas do idioma de destino. As frases e as estruturas gramaticais devem ser precisas e adequadas ao contexto.

- Coerência: O texto traduzido deve ter uma coerência adequada ao longo da tradução. As orações e as ideias devem estar conectadas e organizadas de maneira lógica e compreensível.

- Perplexidade: A perplexidade é uma medida que avalia o quão surpreendente ou inesperada é uma sequência de palavras em um modelo de linguagem. Portanto, uma perplexidade mais baixa indica que as traduções de GPT são mais coerentes e previsíveis. Em geral, um modelo de linguagem é considerado melhor quando tem uma perplexidade mais baixa, uma vez que indica que o modelo tem uma melhor compreensão do contexto e é capaz de fazer previsões mais precisas.

- Uso de terminologia e estilo adequados: A tradução automática deve utilizar a terminologia e o estilo apropriados para o domínio ou campo específico. Isso inclui usar termos técnicos corretos e se adaptar ao tom e registro do texto original.

- Naturalidade: O texto traduzido deve soar natural e não revelar sinais óbvios de que tenha sido gerado por máquina. Deve ser fluido e fácil de ler, sem frases ou construções estranhas ou forçadas.

- Comparisons of Unaligned Source Words se refere a comparações realizadas entre palavras de origem não alinhadas no contexto da tradução automática.

Na tradução automática, é comum trabalhar com conjuntos de dados paralelos que contém orações em um idioma de origem e suas traduções em outro idioma. No entanto, o exato alinhamento entre as palavras do texto original e sua tradução pode ser um processo complexo e desafiante, especialmente quando existem diferenças estruturais ou gramaticais entre os idiomas.

- Comparisons of Unaligned Translation Words: Estas comparações são realizadas para analisar e avaliar as dificuldades associadas com a falta de correspondência exata entre as palavras de origem e as palavras traduzidas no processo de tradução automática.

- Parallel Data Bias (Viés nos Dados Paralelos) se refere à presença de vieses ou desequilíbrios nos conjuntos de dados paralelos utilizados para treinar sistemas de tradução automática. Os conjuntos de dados paralelos contêm orações ou textos no idioma de origem e suas correspondentes traduções em um idioma de destino.

O viés nos dados paralelos pode se manifestar de várias formas:

- Viés de seleção de dados: Os conjuntos de dados paralelos com frequência são compilados de fontes disponíveis, como livros, sites na internet ou documentos específicos. Se a seleção destes dados não for representativa da diversidade linguística ou dos distintos domínios, é possível que um viés nos dados paralelos seja introduzido. Isso pode resultar em um enfoque excessivo em certos temas ou domínios, enquanto outros podem estar subrepresentados.

- Viés de alienação: O processo de alienação das orações do idioma de origem com suas traduções pode introduzir erros e desequilíbrios. Se a alienação não for precisa ou estiver baseada em suposições errôneas, pode haver diferenças na qualidade e coerência das traduções, o que por sua vez pode afetar a qualidade do modelo de tradução automática.

- Viés cultural e linguístico: Os conjuntos de dados paralelos podem refletir vieses culturais, linguísticos ou estereótipos presentes na linguagem utilizada nos textos de origem ou nas traduções.

Conclusões

- Foram discutidas as características das traduções GPT vis-à-vis NMT e foram analisados os aspectos que diferenciam as traduções GPT, enumerando quantitativamente os artefatos de viés da modelação de linguagem, as características de tradução a través de várias direções de idioma, e o viés dos dados paralelos.

- Foram exploradas as capacidades multilíngues dos modelos GPT além da tradução.

- Foi demonstrado que os mecanismos computacionais que operam por trás dos modelos LLM e NMT produzem artefatos de tradução que podem ser diferenciados e medidos quantitativamente.

- As traduções produzidas por GPT têm mais fluidez, obtendo consistentemente menor perplexidade. Ao mesmo tempo, os resultados mostram que os sistemas GPT podem produzir textos altamente fluidos e competitivos, incluindo os domínios científicos.

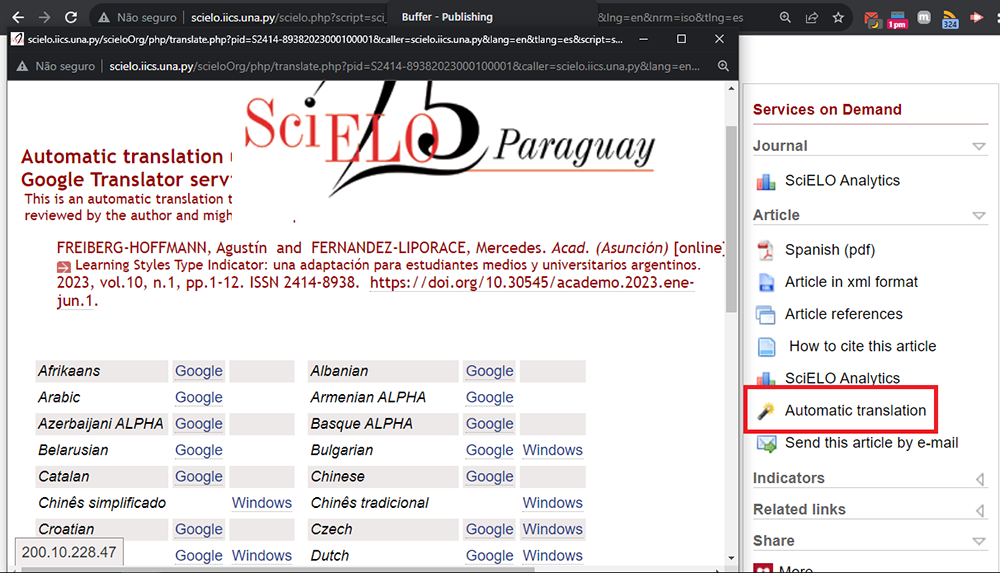

Do ponto de vista da plataforma SciELO, estas ferramentas testadas de tradução automática no âmbito científico são muito importantes, pois um dos serviços prestados na interface de consulta, entre muitos outros, é oferecer a tradução instantânea do artigo a partir do idioma original a qualquer daqueles disponíveis no tradutor Google mencionado acima.

A análise apresentada confirma que SciELO está oferecendo acesso livre em qualquer idioma da produção científica com a mais alta qualidade disponível.

Comentários do autor

A elaboração desta nota foi totalmente automática, nenhum ser humano interveio na sua geração. A menção de um autor pessoal é apenas por questões de ética e responsabilidade editorial.

O humano que assina a nota colabora voluntariamente como ghostwriter (autor fantasma).

Outra nota: o que se afirma acima é falso.

Posts da série sobre Inteligência Artificial (IA)

- GPT, tradução automática e o quão bons eles são: uma avaliação abrangente

- Inteligência Artificial e a comunicação da pesquisa

- IA: Como detectar textos produzidos por chatbox e seus plágios

- Pesquisa e comunicação científica, IA e legislação iminente

- ¿Puede la IA hacer arbitrajes confiables de artículos científicos? (apenas em espanhol)

- ¿Es que la Inteligencia Artificial tiene alucinaciones? (apenas em espanhol)

Notas

1. HENDY, A., et al. How Good Are GPT Models at Machine Translation?: A Comprehensive Evaluation. arXiv [online]. 2023 [viewed 14 August 2023]. https://doi.org/10.48550/arXiv.2302.09210. Available from: https://arxiv.org/abs/2302.09210v1

2. AGRAWAL, S., et al. In-context Examples Selection for Machine Translation. arXiv [online]. 2022 [viewed 14 August 2023]. https://doi.org/10.48550/arXiv.2212.02437. Available from: https://arxiv.org/abs/2212.02437

3. WMT: https://machinetranslate.org/wmt Es el evento principal para la tradução automática y la investigação de la tradução automática. La conferencia se lleva a cabo anualmente en conexión con conferencias mais grandes sobre el procesamiento del lenguaje natural.

4. Principais tradutores automáticos e suas arquiteturas:

- DeepL – https://www.deepl.com/en/translator – neural machine translation

- Google Translate – https://translate.google.com/ – neural machine translation

- Yandex Translate – https://translate.yandex.com/en/ – self-learning statistical machine translation

- Microsoft Bing – https://www.bing.com/translator/ – self-learning statistical machine translation

- OpenNMT – https://opennmt.net/ – neural machine translation

- MarianNMT – https://marian-nmt.github.io/ – neural machine translation de Microsoft

5. WMT usa uma nomenclatura específica para identificar os documentos modelo que são utilizados nos testes de tradução automática. A nomenclatura segue o seguinte formato:

[Idioma de origem] – [Idioma de destino]

Exemplo. Caso se trate de documentos de tradução do inglês ao francês, a nomenclatura seria “en-fr”.

- Inglês a Alemão: en-de

- Francês a Inglês: fr-en

- Espanhol a Inglês: es-en

Em geral, os conjuntos de dados de teste de WMT são denominados utilizando uma combinação do ano da conferência e uma descrição que indica o idioma e tipo dos dados.

Por exemplo, alguns exemplos comuns de nomenclatura para conjuntos de dados de teste de WMT poderiam ser:

- WMTXX-News: Conjunto de dados de teste baseado em notícias para o ano XX da conferência.

- WMTXX-Europarl: Conjunto de dados de teste baseado nos debates do Parlamento Europeu para o ano XX da conferência.

Referências

HENDY, A., et al. How Good Are GPT Models at Machine Translation?: A Comprehensive Evaluation. arXiv [online]. 2023 [viewed 14 August 2023]. https://doi.org/10.48550/arXiv.2302.09210. Available from: https://arxiv.org/abs/2302.09210v1

AGRAWAL, S., et al. In-context Examples Selection for Machine Translation. arXiv [online]. 2022 [viewed 14 August 2023]. https://doi.org/10.48550/arXiv.2212.02437. Available from: https://arxiv.org/abs/2212.02437

Links externos

arXiv: https://arxiv.org

DeepL: https://www.deepl.com/en/translator

Google Translate: https://translate.google.com/

MarianNMT: https://marian-nmt.github.io/

Microsoft Bing: https://www.bing.com/translator/

Microsoft Translator: https://www.microsoft.com/pt-br/translator/

OpenNMT: https://opennmt.net/

WMT | The Conference on Machine Translation: https://machinetranslate.org/wmt

Yandex Translate: https://translate.yandex.com/en/

Sobre Ernesto Spinak

Colaborador do SciELO, engenheiro de Sistemas e licenciado em Biblioteconomia, com diploma de Estudos Avançados pela Universitat Oberta de Catalunya e Mestre em “Sociedad de la Información” pela Universidad Oberta de Catalunya, Barcelona – Espanha. Atualmente tem uma empresa de consultoria que atende a 14 instituições do governo e universidades do Uruguai com projetos de informação.

Traduzido do original em espanhol por Lilian Nassi-Calò.

Como citar este post [ISO 690/2010]:

Últimos comentários