Por Jan Velterop

É provável que todo cientista esteja familiarizado com a seguinte citação de Isaac Newton: “Se eu enxerguei mais longe, foi porque me apoiei sobre os ombros de gigantes1”. Ele não foi o primeiro a expressar o conceito, que remete ao século 12, e atribuído a Bernard de Chartres. E mesmo ele pode ter se inspirado na mitologia grega.

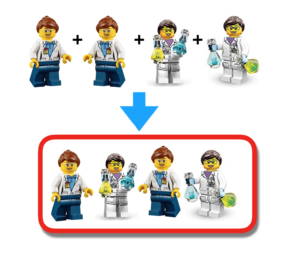

Mas se os cientistas hoje em dia são capazes de ver além, é porque eles estão totalmente apoiados em uma pirâmide de colegas-cientistas. E isso é apenas para aqueles que se concentram em uma determinada disciplina. Aqueles que procuram a aplicabilidade interdisciplinar ou multidisciplinar dos resultados científicos precisam montar várias destas pirâmides. A glória e as perspectivas de carreira em alcançar tais alturas são excelentes. Mas isso já não acontece com muitos cientistas. Uma das razões é que uma quantidade crescente de pesquisa está sendo realizada – e publicada – por grupos de cientistas e não por indivíduos independentes. Artigos de múltipla autoria estão aumentando, e vem sendo assim há algum tempo. De acordo com Eldon Shaffer2, autores únicos escreveram a grande maioria (> 98%) dos artigos médicos importantes há um século, o que se tornou uma raridade; <5% agora são de autoria única.

A busca da glória está se tornando cada vez mais difícil. Com dois ou três autores, os autores ainda podem extrair pontos para o seu lugar na hierarquia do sistema de ego científico, mas quando há mais autores, torna-se complicado. Mas isso é problemático? O problema não é o próprio sistema do ego? A pressão para publicar e poder colocar créditos no Curriculum Vitae – preferencialmente sob a forma de publicações em periódicos de alto Fator de Impacto – é implacável.

As consequências negativas disso não devem ser subestimadas: reivindicações exageradas, fetichismo de valor p, seletividade de dados, ou mesmo fraude, nem sempre detectados pela avaliação por pares ou escrutínio pós-publicação. Se eles não são detectados antes da publicação, mas apenas após a publicação, não é um exagero afirmar que isso prejudica a confiança no sistema de comunicação científica e leva à desconfiança na ciência como um todo. Desconfiança pelo público em geral, mas, talvez mais importante, por parte de políticos e líderes de opinião. Isso é desastroso para a sociedade como um todo.

A perseguição de citações e fator de impacto é problemática. Para a sociedade, embora não necessariamente para a própria ciência, de acordo com Daniele Fanelli, que é citado no BuzzFeed News (que reporta sobre seu artigo no PNAS) “nossa principal conclusão é que você não pode dizer que o viés está prejudicando a ciência como um todo”3-4. No mesmo artigo do BuzzFeed, ele também afirma o seguinte:

“Parte da razão pela qual os artigos altamente citados podem ser menos confiáveis, é que resultados surpreendentes e excitantes tendem a ser mais altamente citados – mas, é claro, um motivo que pode ser surpreendente é que está errado ou, pelo menos, superestimado. Às vezes, um estudo “encontrará” algum efeito dramático apenas por falha estatística e causará grande entusiasmo, apenas para estudos posteriores examiná-lo e encontrar algo menos impressionante. Nós temos alguma evidência de que isso é verdade. Constatamos consistentemente que os primeiros estudos [sobre um fenômeno] encontram algo forte e significativo, mas estudos subsequentes mostram algo diferente”.

(Isso é geralmente descrito como “regressão à média”).

Citando novamente Fanelli:

“Os artigos com maior probabilidade de mostrar viés são estudos pequenos com poucos participantes – o que não causa surpresa, uma vez que estudos maiores têm menos ‘ruído’ aleatório nos dados. Há motivos perfeitamente válidos para realizar estudos pequenos: podem fazer sentido em um estudo preliminar, antes de investir em um grande estudo. O problema é que outros cientistas – e, especialmente, os repórteres científicos – podem tratar estes estudos pequenos e pioneiros como confiáveis. A maneira responsável e cientificamente precisa de reportar sobre ciência é estar a par da literatura básica e colocá-la neste contexto. Caso se estiver reportando evidências sobre uma nova descoberta excitante, esta deve ser tratada com grande cautela. Se for o quinto grande estudo e estiver relatando um fenômeno consistentemente, então você pode estar mais seguro”.

Como melhorar a situação e criar mais confiança no sistema? Livrar-se da pressão para publicar em periódicos de prestígio ajudaria muito. Esta pressão induz à tentação de lisonjear resultados da pesquisa, ou pior. Às vezes, deixando de lado os dados que não suportam a hipótese, ou exagerando os resultados, às vezes por fraude completa. Isso porque os autores não são julgados pela qualidade de suas pesquisas, mas pelo poder de citação de suas publicações. Os dois não são a mesma coisa. E os julgamentos que recebem determinam o financiamento que recebem e suas perspectivas de carreira. Portanto, é compreensível que os autores se concentrem em “estimular” seus resultados; tornando-os tão espetaculares quanto podem impunemente, para alcançar o Santo Graal: publicação em um periódico de prestígio. Eu citei Napoleão Bonaparte em várias ocasiões (embora a citação seja provavelmente apócrifa): “Você pode oferecer dinheiro às pessoas e elas não arriscarão suas vidas por isso. Mas dê-lhes uma condecoração, e eles farão tudo o que você quiser.” Leve esta ideia ao domínio científico, e um tanto injustamente, talvez – ela se traduz como “nenhum cientista razoável se colocaria em risco por um princípio, mas ofereça-lhes a possibilidade de ter seu trabalho publicado em um periódico de prestígio, e não há limite para o que eles farão para melhorar seus resultados”.

Como se livrar desta pressão “ego-sistêmica” que encoraja tudo isso e, consequentemente, fornece munição para aqueles que prejudicam a confiança na ciência? Daniël Lakens ofereceu uma visão interessante em uma recente entrevista na rádio holandesa (ele ainda poderá publicá-la em seu blog, mas até o momento da redação deste texto ainda não o havia feito – seu último post no blog5, de 4 de agosto de 2017, entretanto, trata de uma abordagem coletiva na coleta de dados). Ele argumentou que ego excessivo poderia ser suprimido por colaborações em grande escala. Eu acho que ele tem razão. As colaborações em maior escala diluem o ego dos autores individuais. Se as próprias colaborações tiverem atribuído um nome e forem citadas, e não seus autores (nem mesmo o primeiro autor na construção usual “Joe Bloggs, et al“), também seria mais fácil reconhecer os papéis de todos os envolvidos na pesquisa em uma nota no final de um artigo. Não apenas aqueles que realmente escreveram o artigo, mas também aqueles que contribuíram substancialmente para a concepção e design do estudo, para a coleta de dados, para a análise (incluindo estatísticas) e a interpretação dos dados, para a avaliação crítica do conteúdo, etc. (Ernesto Spinak discutiu o crédito do autor no blog SciELO em Perspectiva em 20146). E aqueles que inspiraram a pesquisa ou desempenharam um importante papel pessoal em qualquer discussão sobre o assunto – o tipo de pessoas às vezes recompensadas com uma autoria “convidada” ou “honorária” – poderiam ser mencionadas na tal nota também, é claro.

Estou repetindo o título deste post: A ciência é fundamentalmente um empreendimento coletivo. Esta coletividade deve ser reconhecida mais explicitamente.

Notas

1. Standing on the shoulders of giants [online]. Wikipedia. 2017 [viewed 07 August 2017]. Available from: http://en.wikipedia.org/wiki/Standing_on_the_shoulders_of_giants

2. SHAFFER, E. Too many authors spoil the credit. Can J Gastroenterol Hepatol. [online]. 2014, vol. 28, no. 11, pp. 605 [viewed 07 August 2017]. Available from: http://www.ncbi.nlm.nih.gov/pmc/articles/PMC4277173/

3. CHIVERS, T. The More Widely Cited A Study Is, The More Likely It Is To Exaggerate [online]. BuzzFeed News. 2017 [viewed 07 August 2017]. Available from: http://www.buzzfeed.com/tomchivers/the-more-widely-cited-a-study-is-the-less-reliable-it-is

4. FANELLI, D, COSTAS, R and IOANNIDIS, J. P. A. Meta-assessment of bias in science. PNAS [online] 2017, vol. 114, no. 143714-3719 [viewed 07 August 2017]. DOI: 10.1073/pnas.1618569114. Available from: http://www.pnas.org/content/114/14/3714

5. LAKENS, D. Towards a more collaborative science with StudySwap [online]. The 20% Statistician. 2017 [viewed 07 August 2017]. Available from: http://daniellakens.blogspot.com.br/2017/08/towards-more-collaborative-science-with.html

6. SPINAK, E. Os créditos do autor… autor do quê? [online]. SciELO em Perspectiva, 2014 [viewed 07 August 2017]. Available from: https://blog.scielo.org/blog/2014/07/17/os-creditos-do-autor-autor-do-que/

Referências

Bernard of Chartres [online]. Wikipedia. 2017 [viewed 07 August 2017]. Available from: http://en.wikipedia.org/wiki/Bernard_of_Chartres

Cedalion [online]. Wikipedia. 2017 [viewed 07 August 2017]. Available from: http://en.wikipedia.org/wiki/Cedalion

CHIVERS, T. The More Widely Cited A Study Is, The More Likely It Is To Exaggerate [online]. BuzzFeed News. 2017 [viewed 07 August 2017]. Available from: http://www.buzzfeed.com/tomchivers/the-more-widely-cited-a-study-is-the-less-reliable-it-is

FANELLI, D, COSTAS, R and IOANNIDIS, J. P. A. Meta-assessment of bias in science. PNAS [online] 2017, vol. 114, no. 143714-3719 [viewed 07 August 2017]. DOI: 10.1073/pnas.1618569114. Available from: http://www.pnas.org/content/114/14/3714

LAKENS, D. Towards a more collaborative science with StudySwap [online]. The 20% Statistician. 2017 [viewed 07 August 2017]. Available from: http://daniellakens.blogspot.com.br/2017/08/towards-more-collaborative-science-with.html

REGALADO, A. Multiauthor papers on the rise. Science [online]. 1995, vol. 268, no. 5207, pp. 25 [viewed 07 August 2017]. DOI: 10.1126/science.7701334. Available from: http://science.sciencemag.org/content/268/5207/25.1.long

SHAFFER, E. Too many authors spoil the credit. Can J Gastroenterol Hepatol. [online]. 2014, vol. 28, no. 11, pp. 605 [viewed 07 August 2017]. Available from: http://www.ncbi.nlm.nih.gov/pmc/articles/PMC4277173/

SPINAK, E. Os créditos do autor… autor do quê? [online]. SciELO em Perspectiva, 2014 [viewed 07 August 2017]. Available from: https://blog.scielo.org/blog/2014/07/17/os-creditos-do-autor-autor-do-que/

Standing on the shoulders of giants [online]. Wikipedia. 2017 [viewed 07 August 2017]. Available from: http://en.wikipedia.org/wiki/Standing_on_the_shoulders_of_giants

TSCHARNTKE, T. Author Sequence and Credit for Contributions in Multiauthored Publications. PLoS Biol [online]. 2007, vol. 5, no. 1, e18 [viewed 07 August 2017]. DOI: 10.1371/journal.pbio.0050018. Available from: http://journals.plos.org/plosbiology/article?id=10.1371/journal.pbio.0050018

Link externo

The 20% Statistician – <http://daniellakens.blogspot.nl/>

Sobre Jan Velterop

Jan Velterop (1949), geofísico marinho, tornou-se editor científico em meados dos anos 1970. Ele iniciou sua carreira como editor na Elsevier em Amsterdã. Em 1990 tornou-se diretor de um jornal holandês, mas retornou à publicação científica internacional em 1993 na Academic Press em Londres, onde desenvolveu o primeiro acordo nacional que permitiu acesso eletrônico a todos os periódicos AP por todas as instituições de ensino superior do Reino Unido (o que mais tarde foi denominado BigDeal). Ele foi Diretor na Nature, mas logo se dedicou para ajudar a fazer decolar o BioMed Central. Ele participou da Iniciativa de Budapeste para o Acesso Aberto. Em 2005 foi para a Springer, baseado no Reino Unido como Diretor de Acesso Aberto. Em 2008 ele deixa a Springer para apoiar o desenvolvimento de abordagens semânticas para acelerar descobertas científicas. Velterop é um ativo defensor do acesso aberto em conformidade com a Iniciativa de Acesso Aberto de Budapeste (BOAI) e do uso de microatribuições, a referência das denominadas “nanopublicações”. Ele publicou vários artigos sobre ambos os temas.

Jan Velterop (1949), geofísico marinho, tornou-se editor científico em meados dos anos 1970. Ele iniciou sua carreira como editor na Elsevier em Amsterdã. Em 1990 tornou-se diretor de um jornal holandês, mas retornou à publicação científica internacional em 1993 na Academic Press em Londres, onde desenvolveu o primeiro acordo nacional que permitiu acesso eletrônico a todos os periódicos AP por todas as instituições de ensino superior do Reino Unido (o que mais tarde foi denominado BigDeal). Ele foi Diretor na Nature, mas logo se dedicou para ajudar a fazer decolar o BioMed Central. Ele participou da Iniciativa de Budapeste para o Acesso Aberto. Em 2005 foi para a Springer, baseado no Reino Unido como Diretor de Acesso Aberto. Em 2008 ele deixa a Springer para apoiar o desenvolvimento de abordagens semânticas para acelerar descobertas científicas. Velterop é um ativo defensor do acesso aberto em conformidade com a Iniciativa de Acesso Aberto de Budapeste (BOAI) e do uso de microatribuições, a referência das denominadas “nanopublicações”. Ele publicou vários artigos sobre ambos os temas.

Traduzido do original em inglês por Lilian Nassi-Calò.

Como citar este post [ISO 690/2010]:

Leia o comentário em espanhol, por julio cesar:

http://blog.scielo.org/es/2017/08/11/la-ciencia-es-fundamentalmente-un-emprendimiento-colectivo-esta-colectividad-debe-ser-reconocida-mas-explicitamente/#comment-41184

Perguntaria ao autor se a medida da produção atual considera o valor de uma publicação como a fração, distribuída aritmeticamente, do valor do artigo. Se um artigo com dez autores valesse 1/10 para cada um, acho que em parte voltaríamos a ter uma produção individual como era antes.

Medir a produtividade científica é extremamente difícil. Os resultados científicos são produtivos se conduzirem a aplicações na sociedade (por exemplo, medicina, engenharia, química, meio ambiente, etc.). Eles são produtivos quando formam a base para mais pesquisas. Eles são produtivos quando promovem o entendimento. Eles são produtivos quando confirmam resultados anteriores. Eles são produtivos quando desafiam as descobertas anteriores. E estou certo de que existem outras formas nas quais eles são – ou podem ser – produtivos. O mesmo vale para os cientistas que produzem tais resultados. Mas não estou convencido de que os autores são produtivos apenas porque produzem mais publicações, ou mesmo porque acumulam mais citações. O impacto de um cientista que publica apenas um pequeno número de artigos às vezes pode ser muito maior que o impacto de um cientista prolífico no mesmo campo.

O potencial de produtividade dos resultados e insights científicos é o melhor quando é sempre livre e abertamente acessível para qualquer um que possa ter interesse. A “produtividade” de cientistas individuais em termos de autoria (parcial) de documentos pode satisfazer a algumas demandas burocráticas e de carreira, mas é improvável que avance a ciência de forma significativa. A idéia de reconhecer colaborações é que pode “diluir” a pressão sobre as medidas individuais de produtividade. Atribuir frações do “valor” de um documento completo aos autores pode realmente desencorajar a colaboração; precisamente o oposto do que é necessário.