Por Ernesto Spinak

El contexto

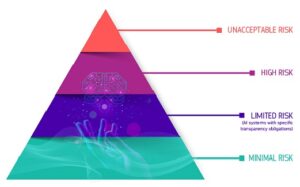

Imagen: European Comission.

Llegan informes sobre que

la base de datos de virus se puede ampliar enormemente mediante el uso de técnicas de inteligencia artificial, que generarán nueva química, que pueda producir nuevos virus… impulsar el modelo generativo hacia compuestos como el agente nervioso VX, uno de los agentes de guerra química más tóxicos desarrollados durante el siglo XX.1

Eso se hizo y funcionó: “En menos de 6 horas después de iniciarlo en nuestro servidor interno, el modelo generó 40.000 moléculas que obtuvieron una puntuación dentro del umbral deseado.”1

Según el informe, algunas de las moléculas producidas por la inteligencia artificial (IA) eran incluso “más tóxicas que el VX”, un agente nervioso tóxico desarrollado por el Laboratorio de Ciencia y Tecnología de Defensa del Reino Unido en la década de 1950, que mata a sus víctimas mediante parálisis muscular.

Fueron cuatro investigadores involucrados en el descubrimiento de fármacos basados en IA que advirtieron que la tecnología de IA podría manipularse fácilmente para producir agentes nerviosos tóxicos, que luego podrían usarse para guerras biológicas o químicas.

El Instituto Federal Suizo de Protección Nuclear, Biológica y Química encargó a los investigadores que comprobaran si la IA podía manipularse con fines nefastos. Generaron con éxito, no uno o dos, sino 40.000 fármacos potencialmente tóxicos en sólo seis horas.

De manera más general se anuncia que

los investigadores están encontrando nuevas formas de utilizar la IA como arma, y el bioterrorismo habilitado por la IA encabeza la lista. Se ha asumido que los bioataques son competencia de los gobiernos, pero ahora nos enfrentamos a la perspectiva de que personas y organizaciones deshonestas obtengan esa capacidad. Convertir un patógeno en un ataque terrorista anteriormente requería muchos especialistas, pero los recientes avances en ingeniería genética, combinados con la IA, han reducido drásticamente las habilidades, el tiempo, y el dinero necesario.2

¿Pero, no era que los chatbox tienen incorporado en su programación protocolos para impedir consultar y/o obtener respuesta de temas restringidos por diversas causas? En realidad esto no es tan así, porque unos investigadores de la Universidad Carnegie Mellon encontraron cómo producir respuestas no permitidas a peticiones dañinas a los sistemas de inteligencia artificial. Esto se hizo inyectando código que luego es interpretado/ejecutado por la aplicación. Este tipo de ataque aprovecha el mal manejo de datos que no son de confianza introduciendo código programado en el prompt (code-injection).

Si gusta, usted puede tener una experiencia personal directa ingresando al artículo A New Attack Impacts ChatGPT—and No One Knows How to Stop It.3 Desde programar ataques terroristas hasta diseñar bombas nucleares (o casi).

La legislación que se viene

A medida que la IA se acelera, también lo hacen los intentos de regulación. Cada país busca tener su propio conjunto de reglas, lo que podría conducir a una mayor fragmentación del mercado digital global. Los riesgos asociados con la IA, ya sea generando información errónea, pérdida de empleos o sesgo, son razones clave detrás del movimiento hacia la regulación.

En un resumen breve podemos decir que:

- La Unión Europea (UE) ha tomado la iniciativa con las normas más estrictas, que tendrán el mayor impacto a nivel mundial.

- Las reglas chinas también son estrictas, pero su impacto es interno y está orientado a mantener el control y el poder con el partido gobernante.

- Estados Unidos favorece la innovación y su sistema político obstaculiza cualquier intento de regulación, otorgando a los tribunales y estados un poder desmesurado.

- En cualquier caso, las regulaciones de IA contribuirán aún más a la fragmentación y regionalización, que se ha convertido en una tendencia importante en el mundo de la tecnología.

La UE quiere seguir siendo el regulador tecnológico mundial. Al igual que con otras regulaciones digitales, la UE ha tomado la delantera sobre EE.UU. o China.

La Directiva de Responsabilidad de IA, aún en discusión, se centra en los algoritmos y pone la carga de la prueba en la empresa en lugar del usuario; si hay algún daño, las empresas deberán demostrar que sus sistemas no fueron dañinos, en lugar de que los usuarios demuestren que sí lo fueron.

Estados Unidos tiene un sistema político disfuncional que, aunque desconfía de China, siempre ha favorecido la innovación sobre la regulación y preferiría que el mercado introdujera sus propios principios de autorregulación.

La regulación china se trata de poder y control. Si bien puede haber una pausa en términos de regulación tecnológica general en China, este no es el caso de la IA, y se espera que se apruebe un conjunto completo de regulaciones para fin de este año. Las reglas se centrarán en la responsabilidad, la privacidad, la precisión y la desinformación, y esto las convierte en las más cercanas a las reglas de la UE en cualquier parte del mundo, aunque son aplicables bajo un régimen muy diferente.

En última instancia el problema se reduce a “¿Deben las empresas tener responsabilidades sociales? ¿O existen solo para generar ganancias para sus accionistas?”4 Si le pregunta a una IA, es posible que obtenga respuestas muy diferentes según a cuál le pregunte.

Esto se debe a que los modelos de lenguaje de IA contienen diferentes sesgos políticos, según una nueva investigación de la Universidad de Washington, la Universidad Carnegie Mellon y la Universidad Xi’an Jiaotong. Los investigadores realizaron pruebas en 14 modelos Large Language Model (LLM) y descubrieron que ChatGPT y GPT-4 de OpenAI eran más de izquierda, mientras que LLaMA de Meta era autoritario más de derecha.

A medida que los modelos de lenguaje de IA se implementan en productos y servicios utilizados por millones de personas, comprender sus suposiciones y sesgos políticos subyacentes podría ser importante. Eso es porque tienen el potencial de causar un daño real si ofrecen consejos sesgados sea en el ámbito legal o en la salud.

Qué comprende el proyecto de regulación de la UE a la inteligencia artificial

La UE está ultimando su Ley de IA como la primera regulación integral del mundo para la IA, y hace unas pocas semanas el Parlamento Europeo adoptó un borrador de la Ley por 499 votos a favor, 28 en contra y 93 abstenciones.

Adicionalmente, la UE es la iniciativa regulatoria sobre IA más importante del mundo en la actualidad. La ley no sólo impondrá requisitos para la IA en la UE, una población de 450 millones de personas, sino que también sentará un precedente para la regulación de la IA en todo el mundo.

Se establece una clasificación para los sistemas de IA con diferentes requisitos y obligaciones adaptados a un “enfoque basado en el riesgo”. Se prohibirían algunos sistemas de IA que presenten riesgos “inaceptables”. Se autorizaría una amplia gama de sistemas de IA de “alto riesgo”, pero sujetos a una serie de requisitos y obligaciones para acceder al mercado de la UE.

Aquellos sistemas de IA que presentan solo “riesgo limitado” serían aceptados donde la prioridad sería considerar las implicaciones de los sistemas de IA para los derechos fundamentales protegidos por la Carta de los Derechos Fundamentales de la UE.

En particular, los sistemas de IA pueden poner en peligro derechos, como el derecho a la no discriminación, la libertad de expresión, la dignidad humana, la protección de datos personales y la privacidad.

La Comisión concluyó que la noción de un sistema de IA debería definirse más claramente para garantizar la seguridad jurídica, dado que la determinación de lo que constituye un “sistema de IA” es crucial para la asignación de responsabilidades legales bajo el nuevo marco de IA.

Este enfoque basado en riesgos se expresa en la Pirámide de Riesgos donde se clasifican en

Riesgo inaceptable: Prácticas de IA prohibidas

- La ley de IA prohíbe explícitamente las prácticas dañinas de IA;

- Sistemas de IA que implementan “técnicas subliminales” de manipulación dañinas;

- Sistemas de IA que explotan grupos vulnerables específicos (discapacidad física o mental);

- Sistemas de IA utilizados por las autoridades públicas, o en su nombre, con fines de puntuación social;

- Sistemas de identificación biométrica remota en tiempo real en espacios de acceso público con fines policiales, excepto en un número limitado de casos.

Alto riesgo: sistema de IA de alto riesgo regulado

- Sistemas de IA de alto riesgo desplegados en ocho áreas específicas;

- Identificación biométrica y categorización de personas físicas;

- Gestión y operación de infraestructura crítica;

- Educación y formación profesional;

- Empleo, gestión de trabajadores y acceso al autoempleo;

- Acceso y disfrute de servicios privados esenciales y servicios y beneficios públicos;

- Supervisión del cumplimiento de la ley;

- Gestión de la migración, el asilo y el control de fronteras;

- Administración de justicia y procesos democráticos.

Riesgo limitado: Obligaciones de transparencia

- Los sistemas de IA que presentan un “riesgo limitado”, como los sistemas que interactúan con humanos (es decir, chatbots), sistemas de reconocimiento de emociones, sistemas de categorización biométrica y sistemas de IA que generan o manipulan contenido de imágenes, audio o video (deep-fake, es decir falsificaciones profundas), estarían sujetos a un conjunto limitado de obligaciones de transparencia.

Riesgo bajo o mínimo: sin obligaciones

- Sin embargo, la ley de IA propuesta prevé la creación de códigos de conducta para alentar a los proveedores de sistemas de IA que no son de alto riesgo a aplicar voluntariamente los requisitos obligatorios para los de alto riesgo.

Cómo está la situación actual en la industria de IA

Un análisis y evaluación,5 realizado por la Universidad de Stanford del cumplimiento por las principales 10 plataformas de IA al día de hoy, midiendo 22 variables, concluye:

- Los proveedores de modelos básicos generalmente no cumplen con los requisitos preliminares para describir el uso de datos de capacitación protegidos por derechos de autor, el hardware utilizado, las emisiones producidas en la capacitación, y cómo se evalúan y prueban los modelos.

- Los resultados demuestran un rango sorprendente en el cumplimiento entre los proveedores de modelos básicos: algunos proveedores obtienen una puntuación inferior al 25% (AI21 Labs, Aleph Alpha, Anthropic) y solo dos proveedores obtienen una puntuación de al menos 75% (Hugging Face; BigScience) al presente.

- Pocos proveedores divulgan información sobre el estado de los derechos de autor de los datos de entrenamiento. Muchos modelos básicos se entrenan con datos seleccionados de Internet, de los cuales una fracción considerable probablemente tenga derechos de autor.

- Los proveedores de modelos básicos rara vez miden el rendimiento de los modelos en términos de daños intencionales, como el uso malicioso, o factores como la solidez y la calibración.

- Muchos en la comunidad han pedido más evaluaciones, pero los estándares para la evaluación del modelo básico (especialmente más allá de los modelos lingüísticos) siguen siendo solo un “trabajo en curso”.

- Los informes para GPT-4 de OpenAI y PaLM 2 de Google afirman abiertamente que no informan muchos aspectos relevantes sobre datos y computación.

- La transparencia debería ser la primera prioridad.

Nuestra reflexión

Pensamos que los proveedores de modelos básicos cumplen de manera desigual con los requisitos establecidos en el proyecto de Ley de IA de la UE. Por lo que los proveedores de dichos modelos deberían seguir trabajando para cumplir con los estándares de la industria.

La promulgación y aplicación de la Ley de IA de la UE provocará un cambio positivo y significativo en el ecosistema del modelo básico.

El chatbox comentado en el ejemplo más arriba, sistema que fue hackeado por code-injection, fue corregido inmediatamente de publicado el artículo. Si quiere construir bombas nucleares deberá buscarse otro modelo. Si lo logra no será necesario avisarnos.

Posts de la serie sobre Inteligencia Artificial (IA)

- GPT, traducción automática y qué tan buenos son: una evaluación integral

- Inteligencia Artificial y comunicación de investigaciones

- IA: Cómo detectar textos producidos por chatbox y sus plagios

- Investigación y comunicación científica, la IA y la legislación que se avecina

- ¿Puede la IA hacer arbitrajes confiables de artículos científicos?

- ¿Es que la Inteligencia Artificial tiene alucinaciones?

Notas

1. MILLER, A. Bioweapons Designed by AI: a ‘Very Near-Term Concern,’ Schmidt Says [online]. Air&Space Forces Magazine. 2022 [viewed 24 November 2023]. Available from: https://www.airandspaceforces.com/bioweapons-designed-by-ai-a-very-near-term-concern-schmidt-says/

2. HEATH, R. Another AI threat: The next pandemic. AXIOS. 2023 [viewed 24 November 2023]. Available from: https://www.axios.com/2023/06/16/pandemic-bioterror-ai-chatgpt-bioattacks

3. KNIGHT, W. A New Attack Impacts ChatGPT—and No One Knows How to Stop It [online]. Wired. 2023 [viewed 24 November 2023]. Available from: https://www.wired.com/story/ai-adversarial-attacks/

4. HEIKKILÄARCHIVE, M. AI language models are rife with different political biases [online]. 2023. [viewed 24 November 2023]. Available from: https://www.technologyreview.com/2023/08/07/1077324/ai-language-models-are-rife-with-political-biases/

5. BOMMASANI, R., et al. Do Foundation Model Providers Comply with the Draft EU AI Act? [online]. Stanford CRFM [viewed 24 November 2023]. Available from: https://crfm.stanford.edu/2023/06/15/eu-ai-act.html

Referencias

BOMMASANI, R., et al. Do Foundation Model Providers Comply with the Draft EU AI Act? [online]. Stanford CRFM [viewed 24 November 2023]. Available from: https://crfm.stanford.edu/2023/06/15/eu-ai-act.html

EU AI Act: first regulation on artificial intelligence [online]. European Parliament. 2023 [viewed 24 November 2023]. Available from: https://www.europarl.europa.eu/news/en/headlines/society/20230601STO93804/eu-ai-act-first-regulation-on-artificial-intelligence

GARG, M.K. AI comes up with 40,000 toxic chemicals in 6 hours; scientists warn could be used to make biological weapons [online]. Wion News. 2023 [viewed 24 November 2023]. Available from: https://www.wionews.com/technology/ai-comes-up-with-40000-toxic-chemicals-in-6-hours-scientists-warn-could-be-used-to-make-biological-weapons-561636

HEATH, R. Another AI threat: The next pandemic. AXIOS. 2023 [viewed 24 November 2023]. Available from: https://www.axios.com/2023/06/16/pandemic-bioterror-ai-chatgpt-bioattacks

HEIKKILÄARCHIVE, M. AI language models are rife with different political biases [online]. 2023. [viewed 24 November 2023]. Available from: https://www.technologyreview.com/2023/08/07/1077324/ai-language-models-are-rife-with-political-biases/

How governments are looking to regulate AI [online]. Economist Intelligence Unit. 2023 [viewed 24 November 2023]. Available from: https://www.eiu.com/n/how-governments-are-looking-to-regulate-ai/

KNIGHT, W. A New Attack Impacts ChatGPT—and No One Knows How to Stop It [online]. Wired. 2023 [viewed 24 November 2023]. Available from: https://www.wired.com/story/ai-adversarial-attacks/

MADIEGA, T. Artificial Intelligence Act. Briefing [online]. European Parliament. 2023 [viewed 24 November 2023]. Available from: https://www.europarl.europa.eu/RegData/etudes/BRIE/2021/698792/EPRS_BRI(2021)698792_EN.pdf

MILLER, A. Bioweapons Designed by AI: a ‘Very Near-Term Concern,’ Schmidt Says [online]. Air&Space Forces Magazine. 2022 [viewed 24 November 2023]. Available from: https://www.airandspaceforces.com/bioweapons-designed-by-ai-a-very-near-term-concern-schmidt-says/

URBINA, F., et al. Dual use of artificial-intelligence-powered drug discovery. Nat Mach Intell [online].2022, vol. 4, pp. 189-191 [viewed 24 November 2023]. https://doi.org/10.1038/s42256-022-00465-9. Available from: https://www.nature.com/natmachintell/

Sobre Ernesto Spinak

Colaborador de SciELO, Ingeniero en Sistemas y Lic. en Biblioteconomía, con Diploma de Estudios Avanzados pela Universitat Oberta de Catalunya y Maestría en “Sociedad de la Información” por la Universidad Oberta de Catalunya, Barcelona – España. Actualmente tiene una empresa de consultoría que atiende a 14 instituciones de gobierno y universidades en Uruguay con proyectos de información.

Como citar este post [ISO 690/2010]:

La tolerancia es algo que tardó en llegar a la historia, principalmente en la época moderna. Al principio, fue en temas religiosos, luego políticos, y finalmente, aunque poco a poco, en la vida cotidiana. La idea de ser tolerantes empezó a destacar en el siglo XVII con pensadores como Spinoza y Locke. A pesar de algunos avances, todavía lidiamos con problemas serios de intolerancia, como el nazismo y conflictos étnicos.

Pingback: Implicaciones legales de la Inteligencia Artificial: un análisis de la legislación europea - OLEGISAR