Por Ernesto Spinak

Introducción

Imagen: Wikimedia Commons, 1934.

El uso de la inteligencia artificial (IA), en particular la traducción automática de textos científicos, es un avance irreversible en la publicación académica. Estas herramientas de apoyo son comunes y aceptadas en el proceso editorial por todas las asociaciones científicas.

En el estudio que nos ocupa se analiza el estado del arte de los traductores más avanzados y de uso general donde se corrobora la confiabilidad de esta herramientas de apoyo a la investigación. Se toma como fuentes a publicaciones recientes de arXiv: How Good Are GPT Models at Machine Translation?: A Comprehensive Evaluation,1 In-context Examples Selection for Machine Translation,2 y los documentos de la Conference of Machine Translation (WMT).3

Contexto del experimento

Se comparan las capacidades de traducción multilingüe de las versiones más recientes de GPT-3.5 y los sistemas Neural Machine Translation (NMT) en diferentes dominios temáticos.

GPT-3.5 es una versión avanzada de la arquitectura GPT (Generative Pre-trained Transformer). Esta arquitectura se basa en una red neuronal llamada Transformer, que utiliza mecanismos de atención para procesar y generar texto. El modelo se entrena en grandes cantidades de datos textuales para aprender patrones lingüísticos y contextuales, lo que le permite generar respuestas coherentes y relevantes en función del contexto de la conversación.

Las versiones usadas fueron: GPT3.5 (text-davinci-003, y text-davinci-002), diferentes versiones del modelo de lenguaje GPT desarrollado por OpenAI con diferentes características.

- Capacidad y tamaño:5 (text-davinci-003) es una versión más reciente y más grande en comparación con text-davinci-002; capacidad de generación de texto más avanzada y una mayor cantidad de conocimiento y contexto a su disposición.

- Entrenamiento: Las diferentes versiones del modelo GPT se entrenan con distintos conjuntos de datos y técnicas de aprendizaje. GPT3.5 se entrena con una cantidad masiva de datos textuales de alta calidad de la web, lo que le permite tener un conocimiento más actualizado, extenso e integral (la versión de GPT3.5 fue entrenada con datos hasta 2022).

- Rendimiento y calidad de respuesta:5 (text-davinci-003) se considera una versión mejorada y se espera que genere respuestas más coherentes y precisas.

Por otra parte, los sistemas Neural Machine Translation (NMT) son enfoques diferentes de los usados por GPT para la traducción automática. A continuación, se presentan algunas diferencias clave entre ellos:

El GPT-3.5 se entrena en grandes cantidades de datos textuales generales de diversos dominios y no se enfoca exclusivamente en la traducción. Por otro lado, los sistemas de NMT se entrenan específicamente en pares de oraciones en diferentes idiomas para aprender a traducir de manera más precisa y específica.

Los sistemas de NMT suelen estar más especializados en la traducción automática y están diseñados para optimizar la calidad de la traducción en diferentes dominios y pares de idiomas específicos. GPT-3.5, aunque capaz de realizar traducciones, no está específicamente optimizado para la traducción automática y puede tener limitaciones en términos de terminología especializada y coherencia en el contexto científico.

Los idiomas considerados en este estudio incluyen: inglés, francés, alemán, checo, islandés, chino, japonés, ruso, ucraniano y hausa (que cubren diversos alfabetos y continentes.

Hay varios sistemas de traducción de acceso abierto que son ampliamente utilizados en la comunidad de traducción automática. Algunos de los principales traductores de acceso abierto puede ver en nota 4.

- DeepL utiliza una arquitectura de redes neuronales llamada Redes Neuronales Recurrentes Profundas (Deep Recurrent Neural Networks, DRNN) para su sistema de traducción automática. Esta arquitectura está basada en LSTM (Long Short-Term Memory) y ha demostrado ser eficaz en tareas de traducción.

- Google Translate utiliza una arquitectura de traducción automática llamada Google Neural Machine Translation (GNMT), que es un enfoque basado en redes neuronales para la traducción automática. Esta arquitectura se basa en la arquitectura Transformer, que es una red neuronal que utiliza mecanismos de atención para procesar y traducir texto.

- Microsoft ofrece un servicio de traducción automática llamado Microsoft Translator. Es un sistema basado en la tecnología de traducción automática neuronal (Neural Machine Translation, NMT) y está diseñado para traducir texto de manera eficiente y precisa entre diferentes idiomas.

- OpenNMT es un proyecto de código abierto que ofrece un marco para la construcción y entrenamiento de sistemas de traducción neuronal. Utiliza arquitectura de redes neuronales como LSTM (Long Short-Term Memory) y Transformer para la traducción automática.

- Marian NMT es otro sistema popular de traducción neuronal de acceso abierto. Está basado en la arquitectura Transformer y ofrece implementaciones eficientes para la traducción automática.

Estos son solo algunos ejemplos de traductores de acceso abierto ampliamente utilizados. Cabe destacar que las arquitecturas mencionadas, como LSTM y Transformer, son utilizadas en muchos sistemas de traducción neuronal debido a su capacidad para capturar relaciones a largo plazo en el texto y procesar eficientemente secuencias de palabras. Sin embargo, cada sistema puede tener implementaciones y configuraciones específicas adaptadas a sus necesidades.

DeepL ha ganado reconocimiento por su calidad de traducción y ha sido especialmente elogiado por su capacidad para mantener la coherencia y producir traducciones naturales. Además, el sistema de traducción de DeepL se ha beneficiado del entrenamiento en grandes conjuntos de datos multilingües – 31 idiomas – para mejorar aún más la precisión y la fluidez de las traducciones.

Google ha invertido significativamente en el desarrollo y entrenamiento de modelos de traducción automática basados en la arquitectura GNMT. Además, han aplicado técnicas de aprendizaje automático avanzadas, como el entrenamiento con grandes conjuntos de datos y el uso de técnicas de aumento de datos, para mejorar la calidad y precisión de las traducciones generadas por Google Translate – soporta más de 110 idiomas-.

The Conference on Machine Translation (WMT)

La Conference on Machine Translation (WMT) desempeña un papel crucial en la evaluación y comparación de la tecnología de traducción automática. WMT, con cobertura mundial, es un evento anual que se centra en la evaluación y el avance de los sistemas de traducción automática.

En el marco de WMT, se organizan desafíos de traducción automática en los que los investigadores y desarrolladores de todo el mundo pueden participar. Estos desafíos generalmente incluyen conjuntos de datos de entrenamiento y prueba, que consisten en pares de oraciones en diferentes idiomas. Los participantes entrenan sus modelos de traducción automática utilizando los datos de entrenamiento proporcionados y luego evalúan y comparan sus sistemas utilizando los datos de prueba.

Los datos de prueba utilizados en la WMT generalmente se recopilan y preparan específicamente para cada edición del evento. El proceso de obtención de los datos de prueba puede variar según el año y los organizadores de la conferencia, pero aquí hay algunas formas comunes en las que se obtienen:

- Conjuntos de datos públicos: Se pueden utilizar conjuntos de datos públicos disponibles en línea, como el Parlamentario Europeo (Europarl), que contiene documentos de los debates en el Parlamento Europeo en varios idiomas. Estos conjuntos de datos suelen ser de dominio público y están ampliamente utilizados para la evaluación de sistemas de traducción automática.

- Colaboración con organizaciones y empresas: WMT a menudo colabora con organizaciones y empresas que están dispuestas a proporcionar datos de prueba para la evaluación de sistemas de traducción automática. Estas organizaciones pueden compartir datos de diferentes dominios y temas para evaluar la calidad y el rendimiento de los sistemas de traducción automática.

- Recolección de datos específicos: En algunos casos, se pueden recopilar datos específicamente para la evaluación de WMT. Esto puede implicar la recopilación de textos de diferentes fuentes, como libros, artículos, subtítulos de películas o sitios web, en una variedad de idiomas para crear un conjunto de datos de prueba diverso.

La nomenclatura utilizada por la WMT para los conjuntos de datos de prueba puede variar de una edición a otra. Sin embargo, a menudo se sigue una convención común para nombrar los conjuntos de datos. La nomenclatura se explica en la Nota 5.

Métricas y parámetros de evaluación

Todos los sistemas de traducción, con sus diferentes arquitecturas, usan numerosos parámetros de configuración y ajustes finos para mejorar la precisión y eficiencia de la tarea, que son evaluadas de acuerdo a métricas internacionales usados por WMT. Además de esos parámetros objetivos, se complementan por evaluaciones humanas de parte de lingüistas expertos.

Se muestran a continuación algunas de las métricas de WMT usadas en los artículos analizados:

- Zero-shot learning (ZSL) es un enfoque de aprendizaje automático que busca abordar el desafío de reconocer y clasificar objetos o conceptos para los cuales no se dispone de datos de entrenamiento directo. El objetivo es aprender a reconocer nuevas clases o categorías sin ejemplos previos de entrenamiento y busca la capacidad de generalizar y reconocer clases no vistas durante el entrenamiento.

- Language Modeling Bias (sesgo de modelado del lenguaje) se refiere a los sesgos inherentes o implícitos que pueden estar presentes en los modelos de lenguaje debido a los datos de entrenamiento utilizados para entrenarlos. El sesgo de modelado del lenguaje puede surgir debido a varios factores, incluyendo los siguientes:

- Sesgos en los datos de entrenamiento: Los modelos de lenguaje se entrenan en grandes conjuntos de datos que a menudo reflejan sesgos existentes en la sociedad o en la forma en que se utiliza el lenguaje. Estos sesgos pueden incluir preferencias culturales, estereotipos, desigualdades sociales y otras formas de sesgo lingüístico.

- Sesgos en la selección de datos de entrenamiento: La selección de los datos de entrenamiento puede introducir sesgos si los conjuntos de datos no representan adecuadamente la diversidad de perspectivas y experiencias.

- Reforzamiento de sesgos existentes: Los modelos de lenguaje pueden aprender a reforzar y amplificar ciertos sesgos presentes en los datos de entrenamiento debido a la forma en que se modela el lenguaje y se generan las respuestas.

- Comparisons of Punctuation Insertions (Comparaciones de Inserciones de Puntuación) es un término que se refiere a la evaluación y comparación de diferentes enfoques o sistemas para la inserción de puntuación en texto. La puntuación, como comas, puntos y signos de interrogación, desempeña un papel importante en la estructura y comprensión del texto. Estas comparaciones suelen evaluar la precisión y la calidad de las inserciones de puntuación realizadas por cada sistema en diferentes contextos y escenarios.

- Translation Non-Monotonicity (No Monotonicidad de la Traducción) se refiere a un fenómeno en la traducción automática donde la relación de correspondencia entre las palabras o frases en el texto de origen y el texto de destino no sigue una secuencia lineal o monótona. En otras palabras, la estructura de la traducción no se mantiene en el mismo orden que en el texto original.

En la traducción monotónica, cada elemento en el texto de origen se traduce directamente a un elemento correspondiente en el texto de destino sin cambios significativos en el orden o la estructura. Sin embargo, en algunos casos, especialmente en idiomas con estructuras gramaticales y sintácticas diferentes, la traducción no es monótona y puede implicar reordenamientos o cambios en la estructura.

- Fluency (Fluidez) se refiere a la calidad y naturalidad del texto generado en el idioma de destino. Se evalúa cómo el texto traducido suena y se lee como si hubiera sido escrito por un hablante nativo del idioma objetivo.

La fluidez en la traducción automática se logra al tener en cuenta aspectos como:

- Gramática y sintaxis: Las traducciones deben seguir las reglas gramaticales y sintácticas del idioma de destino. Las frases y las estructuras gramaticales deben ser precisas y adecuadas en el contexto.

- Coherencia: El texto traducido debe tener una coherencia adecuada a lo largo de la traducción. Las oraciones y las ideas deben estar conectadas y organizadas de manera lógica y comprensible.

- Perplejidad: La perplejidad es una medida que evalúa qué tan sorprendente o inesperada es una secuencia de palabras en un modelo de lenguaje. Por lo tanto, una perplejidad más baja indica que las traducciones de GPT son más coherentes y predecibles. En general, un modelo de lenguaje se considera mejor cuando tiene una perplejidad más baja, ya que indica que el modelo tiene una mejor comprensión del contexto y es capaz de hacer predicciones más precisas

- Uso de terminología y estilo adecuados: La traducción automática debe utilizar la terminología y el estilo apropiados para el dominio o campo específico. Esto incluye usar términos técnicos correctos y adaptarse al tono y registro del texto original.

- Naturalidad: El texto traducido debe sonar natural y no revelar señales obvias de que ha sido generado por una máquina. Debe ser fluido y fácil de leer, sin frases o construcciones extrañas o forzadas.

- Comparisons of Unaligned Source Words se refiere a comparaciones que se realizan entre palabras de origen no alineadas en el contexto de la traducción automática.

En la traducción automática, es común trabajar con conjuntos de datos paralelos que contienen oraciones en un idioma de origen y sus traducciones en otro idioma. Sin embargo, la alineación exacta entre las palabras del texto de origen y su traducción puede ser un proceso complejo y desafiante, especialmente cuando hay diferencias estructurales o gramaticales entre los idiomas.

- Comparisons of Unaligned Translation Words: Estas comparaciones se realizan para analizar y evaluar las dificultades asociadas con la falta de correspondencia exacta entre las palabras de origen y las palabras traducidas en el proceso de traducción automática.

- Parallel Data Bias (Sesgo en los Datos Paralelos) se refiere a la presencia de sesgos o desequilibrios en los conjuntos de datos paralelos utilizados para entrenar sistemas de traducción automática. Los conjuntos de datos paralelos contienen oraciones o textos en un idioma de origen y sus correspondientes traducciones en un idioma de destino.

El sesgo en los datos paralelos puede manifestarse de varias formas:

- Sesgo de selección de datos: Los conjuntos de datos paralelos a menudo se recopilan de fuentes disponibles, como libros, sitios web o documentos específicos. Si la selección de estos datos no es representativa de la diversidad lingüística o de los distintos dominios, se puede introducir un sesgo en los datos paralelos. Esto puede resultar en un enfoque excesivo en ciertos temas o dominios, mientras que otros pueden estar subrepresentados.

- Sesgo de alineación: El proceso de alineación de las oraciones del idioma de origen con sus traducciones puede introducir errores y desequilibrios. Si la alineación no es precisa o está basada en suposiciones erróneas, puede haber diferencias en la calidad y coherencia de las traducciones, lo que a su vez puede afectar la calidad del modelo de traducción automática.

- Sesgo cultural y lingüístico: Los conjuntos de datos paralelos pueden reflejar sesgos culturales, lingüísticos o estereotipos presentes en el lenguaje utilizado en los textos de origen o en las traducciones.

Conclusiones

- Se discutieron las características de las traducciones GPT vis-à-vis NMT y se analizaron los aspectos diferenciadores de las traducciones GPT enumerando cuantitativamente los artefactos de sesgo del modelado del lenguaje, las características de traducción a través de varias direcciones de idioma, así como el sesgo de datos paralelos.

- Se exploraron las capacidades multilingües de los modelos GPT más allá de la traducción.

- Se demuestra que los mecanismos computacionales que operan detrás de los modelos LLM y NMT producen artefactos de traducción que puedan diferenciarse y medirse cuantitativamente.

- Las traducciones producidas por GPT tienen más fluidez, obteniendo consistentemente menor perplejidad, Al mismo tiempo, los hallazgos demuestran que los sistemas GPT pueden producir textos altamente fluidos y competitivos incluyendo a los dominios científicos.

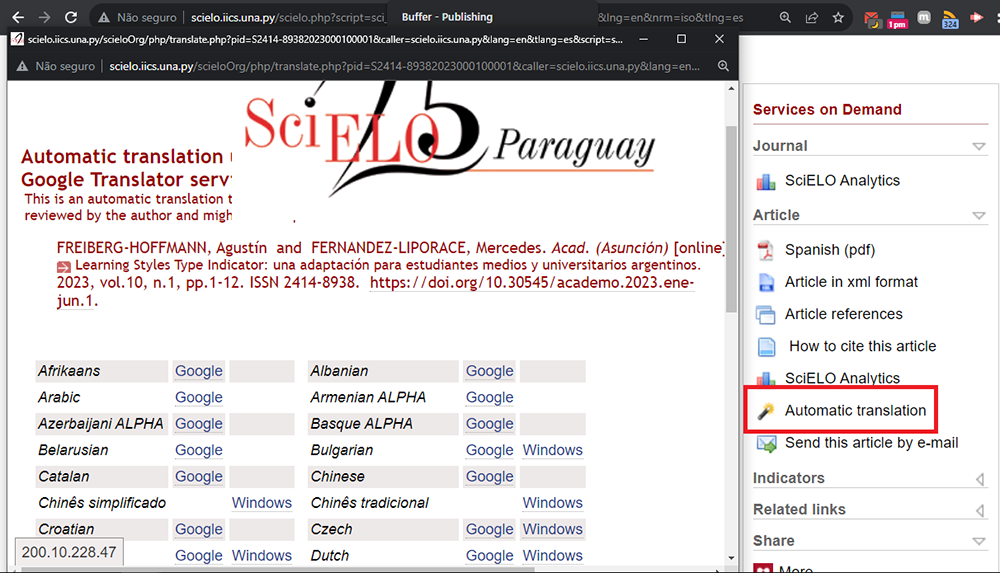

Desde el punto de vista de la plataforma SciELO estas herramientas probadas de traducción automática en el ámbito científico son muy importantes. Porque uno de los servicios prestados en la interfaz de consulta, entre muchos otros, es ofrecer la traducción instantánea del artículo desde el idioma original a cualquiera de los disponibles en el traductor Google mencionado más arriba.

El análisis presentado confirma que SciELO está ofreciendo acceso libre en cuaquier idioma de la producción científica con la más alta calidad disponible.

Comentarios del autor

La preparación de esta nota fue totalmente automática, no ha intervenido ningún ser humano en su generación. La mención de un autor personal es solo por motivos de ética y responsabilidad editorial.

El firmante humano colabora voluntariamente como ghostwriter (autor fantasma).

Otra nota: lo que afirman más arriba es falso.

Posts de la serie sobre Inteligencia Artificial (IA)

- GPT, traducción automática y qué tan buenos son: una evaluación integral

- Inteligencia Artificial y comunicación de investigaciones

- IA: Cómo detectar textos producidos por chatbox y sus plagios

- Investigación y comunicación científica, la IA y la legislación que se avecina

- ¿Puede la IA hacer arbitrajes confiables de artículos científicos?

- ¿Es que la Inteligencia Artificial tiene alucinaciones?

Notas

1. HENDY, A., et al. How Good Are GPT Models at Machine Translation?: A Comprehensive Evaluation. arXiv [online]. 2023 [viewed 14 August 2023]. https://doi.org/10.48550/arXiv.2302.09210. Available from: https://arxiv.org/abs/2302.09210v1

2. AGRAWAL, S., et al. In-context Examples Selection for Machine Translation. arXiv [online]. 2022 [viewed 14 August 2023]. https://doi.org/10.48550/arXiv.2212.02437. Available from: https://arxiv.org/abs/2212.02437

3. WMT: https://machinetranslate.org/wmt Es el evento principal para la tradução automática y la investigação de la tradução automática. La conferencia se lleva a cabo anualmente en conexión con conferencias mais grandes sobre el procesamiento del lenguaje natural.

4. Principales traductores automáticos y sus arquitecturas:

- DeepL – https://www.deepl.com/en/translator – neural machine translation

- Google Translate – https://translate.google.com/ – neural machine translation

- Yandex Translate – https://translate.yandex.com/en/ – self-learning statistical machine translation

- Microsoft Bing – https://www.bing.com/translator/ – self-learning statistical machine translation

- OpenNMT – https://opennmt.net/ – neural machine translation

- MarianNMT – https://marian-nmt.github.io/ – neural machine translation de Microsoft

5. WMT usa una nomenclatura específica para identificar los documentos modelos que se utilizan en las pruebas de traducción automática. La nomenclatura sigue el siguiente formato:

[Idioma de origen] – [Idioma de destino]

Ej. si se trata de documentos de traducción del inglés al francés, la nomenclatura sería “en-fr”.

- Inglés a Alemán: en-de

- Francés a Inglés: fr-en

- Español a Inglés: es-en

Por lo general, los conjuntos de datos de prueba de WMT se denominan utilizando una combinación del año de la conferencia y una descripción que indica el idioma y el tipo de datos.

Por ejemplo, algunos ejemplos comunes de nomenclatura para conjuntos de datos de prueba de WMT podrían ser:

- WMTXX-News: Conjunto de datos de prueba basado en noticias para el año XX de la conferencia.

- WMTXX-Europarl: Conjunto de datos de prueba basado en el Parlamentario Europeo para el año XX de la conferencia.

Referencias

HENDY, A., et al. How Good Are GPT Models at Machine Translation?: A Comprehensive Evaluation. arXiv [online]. 2023 [viewed 14 August 2023]. https://doi.org/10.48550/arXiv.2302.09210. Available from: https://arxiv.org/abs/2302.09210v1

AGRAWAL, S., et al. In-context Examples Selection for Machine Translation. arXiv [online]. 2022 [viewed 14 August 2023]. https://doi.org/10.48550/arXiv.2212.02437. Available from: https://arxiv.org/abs/2212.02437

Enlaces externos

arXiv: https://arxiv.org

DeepL: https://www.deepl.com/en/translator

Google Translate: https://translate.google.com/

MarianNMT: https://marian-nmt.github.io/

Microsoft Bing: https://www.bing.com/translator/

Microsoft Translator: https://www.microsoft.com/pt-br/translator/

OpenNMT: https://opennmt.net/

WMT | The Conference on Machine Translation: https://machinetranslate.org/wmt

Yandex Translate: https://translate.yandex.com/en/

Sobre Ernesto Spinak

Colaborador de SciELO, Ingeniero en Sistemas y Lic. en Biblioteconomía, con Diploma de Estudios Avanzados pela Universitat Oberta de Catalunya y Maestría en “Sociedad de la Información” por la Universidad Oberta de Catalunya, Barcelona – España. Actualmente tiene una empresa de consultoría que atiende a 14 instituciones de gobierno y universidades en Uruguay con proyectos de información.

Como citar este post [ISO 690/2010]:

Muy interesante. Sin embargo, hay un texto que me causa perplejidad, el cual es

“La preparación de esta nota fue totalmente automática, no ha intervenido ningún ser humano en su generación. La mención de un autor personal es solo por motivos de ética y responsabilidad editorial.

El firmante humano colabora voluntariamente como ghostwriter (autor fantasma).

Otra nota: lo que afirman más arriba es falso.”

Podría explicarse esto?

!También estoy muy intrigada!

Pingback: ¿Es que la Inteligencia Artificial tiene alucinaciones? – BABT