El tema de la reproducibilidad de los resultados de la investigación viene mereciendo la atención de la comunidad científica y de la sociedad en los últimos años. La premisa de que la ciencia se corrige a sí misma porque evoluciona en base a la reproducción de estudios anteriores viene siendo cuestionada a la vista del número creciente de evidencias de lo contrario.

El tema de la reproducibilidad de los resultados de la investigación viene mereciendo la atención de la comunidad científica y de la sociedad en los últimos años. La premisa de que la ciencia se corrige a sí misma porque evoluciona en base a la reproducción de estudios anteriores viene siendo cuestionada a la vista del número creciente de evidencias de lo contrario.

La baja confiabilidad de las investigaciones, sin embargo, no parece estar asociada a la mala conducta científica, sino con cuestiones como la insuficiente capacitación del personal técnico e investigadores, el incentivo y la recompensa por resultados positivos en revistas de alto impacto, y el énfasis en la elaboración de afirmaciones ambiciosas, las cuales no están debidamente justificadas por los resultados. Los protocolos experimentales mal diseñados, y el bajo número de muestras y pruebas estadísticas inadecuadas han demostrado ser responsables por la baja reproducibilidad en la investigación.

Estas constataciones, entre otras, llevaron a la creación en el año 2012 de la plataforma en línea Reproducibility Initiative, o Iniciativa en Reproducibilidad, que tiene como objetivo facilitar las comunicación entre investigadores y compañías farmacéuticas para validar y reconocer resultados reproducibles de calidad sobre pruebas pre clínicas publicadas. La plataforma se basa en la red Science Exchange, que incluye más de dos mil laboratorios de 400 instituciones de investigación que reproducen los experimentos. Las presentaciones y los resultados obtenidos son confidenciales y una vez completados y confirmados, cuentan con la etiqueta “validado en forma independiente”. Hay iniciativas semejantes como Science Check, que están contribuyendo a validar los resultados de la investigación en el área clínica y asegurando que estos datos adicionales estén disponibles en repositorios de acceso abierto accesibles a todos.

En vista de este escenario preocupante, las cuestiones que se presentan son: ¿quién es responsable; por qué está ocurriendo; cómo puede ser corregido?

Los investigadores principales responsables de los laboratorios comparten los laureles de los resultados – especialmente cuando son co-autores de las publicaciones – y también deben ser responsables por la exactitud de los resultados, su reproducibilidad, y el tratamiento estadístico de los datos, incluso si el trabajo experimental se llevó a cabo por investigadores con experiencia como pos doctorados. Hay instituciones, como el Laboratorio de Biología Molecular en Heidelberg, Alemania, que limita el tamaño de los laboratorios para que el investigador principal no tenga un número de personas que no pueda supervisar adecuadamente. Cuando esto no ocurre, debería ser creada una estructura jerárquica para controlar mejor los resultados obtenidos.

Desde el punto de vista de las revistas, la disposición abierta de los comentarios en línea es muy útil, así como la presentación de los datos fuentes a los editores y revisores, cuando se los solicite, y para fomentar la publicación de resultados negativos.

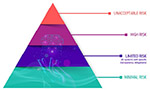

El campo de la psicología también enfrenta la misma crisis de credibilidad en los resultados publicados. Un estudio realizado en 1959 por el estadístico Theodore Sterling llegó a la conclusión de que 97% de los estudios de psicología publicados en las cuatro revistas principales del área reportaron resultados positivos estadísticamente significativos. Cuando el autor repitió el estudio en 1995 obtuvo el mismo resultado. Una de las razones para explicar el exceso de resultados positivos en psicología es que las revistas de alto impacto del área favorecen la publicación de artículos innovadores, interesantes, llamativos que requieren necesariamente resultados positivos. El deseo de los autores en obtener resultados positivos acaba haciendo que se diseñen los experimentos – protocolo experimental, cantidad de muestras y otros pormenores – de forma que sea difícil, casi imposible, su reproducción por otro estudio independiente. De acuerdo con Brian Nosek (apud Yong 2012), un psicólogo social de la Universidad de Virginia, en su área, “To show that ‘A’ is true, you don’t do ‘B’. You do ‘A’ again.”¹ Yong muestra en su artículo un cuadro tomado de Fanelli que muestra la tendencia de publicar resultados positivos en 18 áreas del conocimiento. Las ciencias llamadas “duras” (Ciencias del Espacio, Ciencias de la Tierra, Física, Ciencias de la Computación) están entre las que menos publican resultados positivos. Las Ciencias de la Vida, Química, y Economía están en un estado intermedio y finalmente Psicología y Psiquiatría, Medicina Clínica y Ciencia de los Materiales están en la cima de los que más publican resultados positivos. El autor correlaciona este índice con la mayor falta de reproducibilidad de los ensayos en estas áreas.

Muchas investigaciones en el área clínica usan modelos animales para imitar las técnicas quirúrgicas, el efecto de los medicamentos y otros ensayos en humanos, antes de realizar ensayos clínicos en humanos. Las razones para el uso de conejillos de indias es claro y, de hecho, muchos pacientes se benefician de la investigación sobre nuevos medicamentos, sin embargo, se debe mejorar la calidad de los experimentos en animales.

Los estudios más confiables con modelos animales de enfermedades humanas son los que emplean la aleatorización de las muestras para eliminar las diferencias sistemáticas entre grupos; realizar estudios ciegos, o sea inducir la condición que se está estudiando sin saber si este animal recibirá el fármaco a ser probado; y evaluar los resultados también en forma ciega. Sin embargo, lo que se observa es que a lo sumo, una de cada tres publicaciones sigue estas reglas anti sesgo, lo que indica que los autores, revisores y editores les dan poca importancia. Como se mencionó anteriormente, también el tamaño de la muestra influye directamente en la confiabilidad de los resultados, y hay pocos estudios que reportan cálculos del tamaño de la muestra. La tendencia a publicar sólo resultados positivos, que interesan potencialmente a la industria farmacéutica, también está presente en esta área.

Con el fin de mejorar la fiabilidad de los ensayos con animales, fue creada en 2010 la iniciativa ARRIVE – Animal Research: Reporting In Vivo Studies (Investigación en animales: Informando estudios In Vivo) autora de guías de ensayos validados, entre otros por el Nature Publishing Group. Se espera que las instrucciones recién creadas puedan influir positivamente en los investigadores y cambiar la cultura de la búsqueda de resultados positivos e inmediatos.

Más recientemente, los Institutos Nacionales de Salud de Estados Unidos (NIH) lanzaron medidas para aumentar la reproducibilidad y la transparencia de los resultados de la investigación, con énfasis en el diseño adecuado de los protocolos de investigación. Estos incluyen la promoción del entrenamiento obligatorio de los investigadores de la institución, la producción de guías de buenas prácticas de investigación que estarán a disposición en el sitio Web de los NIH, la creación de checklists para asegurar una evaluación sistemática de las solicitudes de financiamiento para investigación. El NIH estudia formas de aumentar la transparencia de los datos que constituyen la base de los manuscritos enviados para publicación, y la creación de repositorios para depositar datos primarios denominado Data Discovery Index – DDI. Esta plataforma prevé que si otro autor usa datos primarios obtenidos por un investigador, será citado, creando así una nueva métrica de contribución científica desvinculada de las revistas.

En diciembre de 2013, el NIH lanzó un foro online de comentarios sobre artículos publicados – PubMed Commons. Los autores que tienen publicaciones en PubMed pueden escribir comentarios sobre artículos indexados en esta base, así como tener acceso a los comentarios de los colegas. Actualmente más de 2 mil autores se inscribieron y publicaron más de 700 comentarios.

Sin lugar a dudas, la reproducibilidad no es un tema que los NIH puedan enfrentar solos. La comunidad científica, los editores, universidades, asociaciones profesionales, la industria y la sociedad como un todo están siendo invitados a participar en este debate, que tiene por objetivo restaurar la confianza en los resultados de la investigación. De acuerdo con los autores del NIH., el punto crucial es el cambio de actitud en el sistema de incentivos académicos, que actualmente premia publicaciones en revistas de alto Factor de Impacto para conceder financiamiento y lograr promociones en la carrera, a pesar de las recientes iniciativas desestimulando esta práctica.

El escenario de baja reproducibilidad demostrado en los ejemplos anteriores confirma la regla no escrita y compartida entre investigadores académicos y de la industria de que al menos 50% de los estudios publicados, incluso en las revistas de alto FI no son reproducibles por otros laboratorios, e incluso en el mismo sector del laboratorio, los mismos equipos, mismas personas y mismos experimentos. Como ya se mencionó, muchos factores es han sugerido para explicar la baja fiabilidad de los resultados, como muestras de tamaño insuficiente, análisis estadísticos incorrectos o inadecuados, la competencia entre científicos e instituciones por resultados positivos e innovadores, que lleva a confirmar una hipótesis a pesar de que hay muchos resultados (no publicados) que la contradicen.

Según Prinz et al. los editores y revisores no tienen condiciones de repetir los experimentos e ir al fondo de los resultados presentados. Por lo tanto muchos errores no son detectados. Se agrega a esto el hecho de que los trabajos rechazados por una revista terminan siendo publicados por otras, sin cambios o mejoras significativas.

Nota

¹ “… para probar que ‘A’ es verdadero, usted no hace ‘B’, usted repite ‘A’.” (Traducción del autor)

Referencias

La reproducibilidad en los resultados de investigación: la mirada subjetiva. SciELO en Perspectiva. [viewed 25 February 2014]. Available from: <http://blog.scielo.org/es/2014/02/19/la-reproducibilidad-en-los-resultados-de-investigacion-la-mirada-subjetiva/>.

La reproducibilidad en los resultados de investigación: la punta del iceberg. SciELO en Perspectiva. [viewed 28 February 2014]. Available from: <http://blog.scielo.org/es/2014/02/27/la-reproducibilidad-en-los-resultados-de-investigacion-la-punta-del-iceberg/>.

IOANNIDIS, J. P. Why most published research findings are false. PLoS Med. 2005. Available from: <http://www.plosmedicine.org/article/info:doi/10.1371/journal.pmed.0020124>.

BAKER, M. Independent labs to verify high-profile papers. Nature. 14 August 2012. Available from: <http://www.nature.com/news/independent-labs-to-verify-high-profile-papers-1.11176>.

Editorial. Further confirmation needed. Nature Biotechnology. 2012. Available from: <http://www.nature.com/nbt/journal/v30/n9/full/nbt.2335.html>.

Editorial. Must try harder. Nature. 2012. Available from: <www.nature.com/nature/journal/v483/n7391/full/483509a.html>.

YONG, E. Replication studies: Bad copy. Nature. 17 May 2012. Available from: <http://www.nature.com/news/replication-studies-bad-copy-1.10634>.

FANELLI, D. “Positive” Results Increase Down the Hierarchy of the Sciences. PLoS ONE. 2010. Available from: <http://www.plosone.org/article/info%3Adoi%2F10.1371%2Fjournal.pone.0010068>.

MACLEOD, M. Why animal research needs to improve. Nature. 29 September 2011. Available from: <http://www.nature.com/news/2011/110928/full/477511a.html>.

KILKENNY, C. et al. Improving Bioscience Research Reporting: The ARRIVE Guidelines for Reporting Animal Research. PLoS Biology. 2010. Available from: <http://www.plosbiology.org/article/info%3Adoi%2F10.1371%2Fjournal.pbio.1000412>.

COLLINS, F.S., and TABAK, L. A. Policy: NIH plans to enhance reproducibility. Nature. 27 jan 2014. Availabe from: <http://www.nature.com/news/policy-nih-plans-to-enhance-reproducibility-1.14586>.

PubMed Commons: NLM lança versão piloto que permite comentários abertos sobre artigos. SciELO em Perspectiva. [viewed 04 February 2014]. Available from: <http://blog.scielo.org/blog/2013/12/20/pubmed-commons-nlm-lanca-versao-piloto-que-permite-comentarios-abertos-sobre-artigos/>.

Declaração recomenda eliminar o uso do Fator de Impacto na Avaliação de Pesquisa. SciELO em Perspectiva. [viewed 04 February 2014]. Available from: <http://blog.scielo.org/blog/2013/07/16/declaracao-recomenda-eliminar-o-uso-do-fator-de-impacto-na-avaliacao-de-pesquisa/>.

PRINZ, F., et al. Believe it or not: how much can we rely on published data on potential drug targets? Nature Reviews. 2011. Available from: <http://www.nature.com/nrd/journal/v10/n9/full/nrd3439-c1.html>.

Enlaces externos

Reproducibility Initiative – http://www.reproducibility.org/

Science Check – http://www.sciencecheck.org/

Data Discovery Index – DDI – http://grants.nih.gov/grants/guide/rfa-files/RFA-HL-14-031.html

PubMed Commons – http://www.ncbi.nlm.nih.gov/pubmedcommons/

Sobre Lilian Nassi-Calò

Sobre Lilian Nassi-Calò

Lilian Nassi-Calò estudió química en el Instituto de Química de la USP, tiene un doctorado en Bioquímica por la misma institución y un pos doctorado como becaria de la Fundación Alexander von Humboldt en Wuerzburg, Alemania. Después de concluir sus estudios, fue docente e investigadora en el IQ-USP. Trabajó en la industria privada como química industrial y actualmente es Coordinadora de Comunicación Científica en BIREME/OPS/OMS y colaboradora de SciELO.

Traducido del original en portugués por Ernesto Spinak.

Como citar este post [ISO 690/2010]:

Mi nombre es Luis Caldeira, estudiante de psicología de la Universidad Metropolitana de Venezuela. El artículo me parece bastante interesante, en especial el trasfondo que tiene sobre los errores de sesgo confirmatorio que se cometen hoy día en la ciencia y como el principio de falseación de Popper ha sido dejado de lado. Sin embargo tengo una gran curiosidad en saber ¿por qué afirman que los estudios en psicología no pueden ser reproducibles?

Gracias por tu comentario. La noción de que las ciencias consideradas “blandas” son más susceptibles a basarse en resultados de investigación poco reproducibles no es nueva. La jerarquía de las ciencias en orden de “dureza”, que sitúa las ciencias del espacio, ciencias de la tierra, y ciencias de la computación, por ejemplo, en un extremo y la farmacología/toxicología, ciencias de los materiales, y la psicología y psiquiatría en el extremo opuesto es intuitiva, aunque controvertida. El artículo citado en el post (FANELLI, D. “Positive” Results Increase Down the Hierarchy of the Sciences. PLoS ONE. 2010) pone a prueba esta hipótesis analizando el número de publicaciones en cada área que en su mayoría reportan resultados positivos para probar una teoria. Los autores creen que cuanto mayor sea el número de resultados positivos, mayor será la posibilidad de que sean menos reproducibles. Es decir, los autores, en su afán de demostrar sus teorías, son consciente o inconscientemente impulsados a planear los experimentos para que esto ocurra. En las ciencias duras, por otra parte, los resultados negativos son más fácilmente aceptados y publicados, lo que no induce a la búsqueda por resultados positivos y, por lo tanto, menor sesgo.

Pingback: SciELO participa de la Coalición global en defensa de las licencias Creative Commons de acceso a los artículos científicos |

Pingback: REFLEXIÓ MÈTODES D’INVESTIGACIÓ – INVESTIGACIÓ EN COMUNICACIÓ MEDIATITZADA